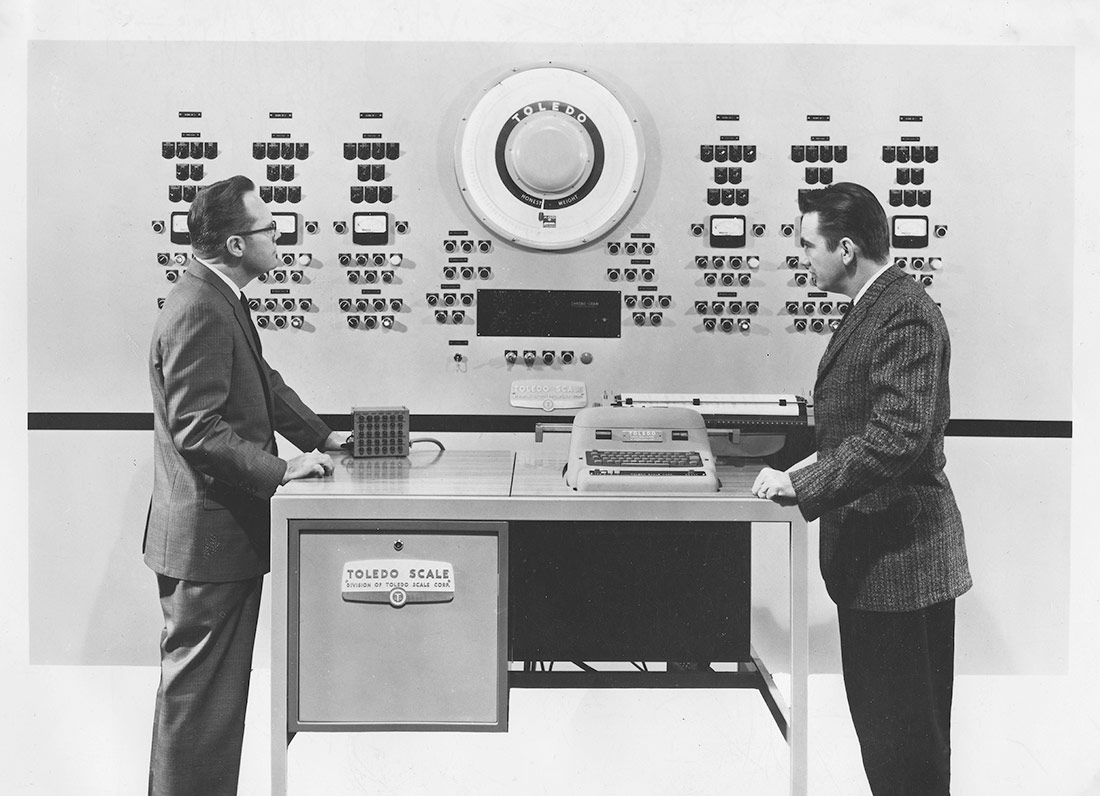

Ordenador electrónico para el control numérico de un proceso industrial | Okänd, Tekniska museet | Dominio público

La manera en que concebimos qué es una inteligencia artificial y cómo la diseñamos tiene serias implicaciones sociales. Marta Peirano revisa los orígenes y la evolución de las IA y aborda sus problemas y peligros en este artículo, que forma parte del catálogo de la exposición «IA: Inteligencia artificial».

Fue en el Segundo Congreso Internacional de Matemáticas, celebrado en París en 1900, donde David Hilbert presentó su famosa lista con veintitrés problemas matemáticos sin resolver. Hilbert era profesor en la Universidad de Gotinga y una estrella del rock de la escena europea. Además de sus Fundamentos de la geometría y sus contribuciones a la lógica, Hilbert era el líder carismático de la tribu fundamentalista, cuya fe establecía lo siguiente: si la matemática no es más que la manipulación de símbolos a través de unas reglas predeterminadas, entonces cualquier problema, por complicado que sea, tiene una solución. Siempre que sepamos traducir todos los problemas a reglas y símbolos calculables. El espíritu entonces era revolucionario. Ahora debería resultarnos familiar.

«¿Quién entre nosotros no estaría contento de levantar el velo tras el que se esconde el futuro; de observar los desarrollos por venir de nuestra ciencia y los secretos de su desarrollo en los siglos que sigan? –declamó en su conferencia de la Sorbona–. ¿Cuál será el objetivo hacia el que tenderá el espíritu de las generaciones futuras de matemáticos? ¿Qué métodos, qué nuevos hechos revelará el nuevo siglo en el vasto y rico campo del pensamiento matemático?». En 1931, un lógico austríaco llamado Kurt Gödel demostró que, de hecho, todo sistema matemático lo suficientemente complejo contenía paradojas irresolubles y que, por tanto, la matemática no se bastaba sola para demostrarse a sí misma ni era la herramienta definitiva para encontrar la verdad. La conversación entre uno y otro constituye el legado científico del siglo XX, y el principio de la generación que parió la bomba atómica, la revolución informática y la inteligencia artificial.

Alan Turing abordaba precisamente uno de los problemas de Hilbert cuando abrió la senda de la computación moderna en 1936. Concretamente, el Entscheidungsproblem o «problema de la decisión». Turing es muy joven y muy ambicioso y el Entscheidungproblem no es cualquier problema. Hilbert dice que ese es el principal problema a resolver de toda la lógica matemática. Tiene que ver con la consistencia de los sistemas lógicos formales, y se pregunta si puede existir un algoritmo capaz de determinar si cualquier proposición es verdadera o falsa. El artículo, titulado «Sobre números computables con una aplicación al Entscheidungsproblem», propone un dispositivo hipotético capaz de realizar cálculos y manipular símbolos siguiendo un conjunto de reglas predeterminadas. Una máquina capaz de implementar cualquier algoritmo y decidir, bajo ese conjunto de premisas o reglas establecidas, si una sentencia matemática cualquiera es válida o no.

Con ayuda de este dispositivo imaginario, Turing consigue demostrar las limitaciones de la computación mecánica y la existencia de problemas indecidibles, como ya había adelantado Kurt Gödel. Al mismo tiempo, su artículo establece las bases de una nueva era de la computación. Muchos consideran que la máquina de Turing es el primer modelo conceptual de unidad central de procesamiento (CPU), con su cinta para almacenar datos y programas y un cabezal que se mueve a lo largo de la cinta, procesando los contenidos según las instrucciones del algoritmo de programación. Lo más importante para nosotros ahora mismo es que inspiró el artículo «Un cálculo lógico de las ideas inmanentes en la actividad nerviosa», en el que Warren McCulloch y Walter Pitts proponen el primer modelo matemático de una red neuronal artificial.

Redes neuronales, 1943

McCulloch y Pitts son la típica pareja científica cinematográfica: McCulloch es un filósofo vividor y cuarentón que ha buscado el secreto de la mente humana en las matemáticas, la teología, la medicina y la psiquiatría. Pitts es un niño prodigio traumatizado por el maltrato que quiere controlar el mundo con una tranquilizadora lógica de enunciados. La chispa es inmediata, los dos desprecian gravemente a Freud. McCulloch se lleva al genio vagabundo a vivir a su casa y allí se disponen a reivindicar a Leibniz, el hombre que se adelantó a todo queriendo codificar todo el pensamiento humano en un lenguaje formal. El nuevo código tendría que ser capaz de expresar conceptos matemáticos, científicos y metafísicos, para ser procesados por un sistema de cálculo lógico universal. En el proceso de intentarlo, se inventan una cosa que llaman red neuronal.

«Un cálculo lógico de las ideas inmanentes en la actividad nerviosa», publicado en 1943, presenta un modelo de computación basado en un sistema de nodos que se encienden y se apagan de acuerdo a reglas predeterminadas. Está claramente inspirado en el trabajo de Santiago Ramón y Cajal, el Nobel navarro que había dibujado las neuronas como una red de unidades físicamente separadas que se excitan unas a otras a través de conexiones sinápticas. Pero la acción se basa en la máquina de Turing, capaz de decidir la validez o la invalidez de un teorema consultando una tabla de valores preconfigurada en su interior.

La neurona electrónica de McCulloch y Pitts tiene dos estados, activo o inactivo que dependen del número de excitaciones o inhibiciones que recibe de las neuronas que tiene alrededor. En otras palabras, es relacional. Hay un umbral mínimo de señales capaz de activar una neurona, y codifican la variación numérica de esas señales como las operaciones fundamentales de la lógica: la conjunción («y»), la disyunción («o») y la negación («no»). La respuesta es activa o inactiva; verdadero o falso; sí o no.

Algunos de los autómatas más famosos de los siglos XVIII y XIX habían sido diseñados para demostrar los procesos de nuestra anatomía que la medicina no había podido observar en acción porque no existían la respiración asistida ni la refrigeración. El pato de Jacques Vaucanson demostraba el sistema digestivo, comiendo grano y dejando un elocuente caminito de residuos a su paso. El flautista imitaba el sistema respiratorio, aspirando y soplando para interpretar su canción. El turco jugador de ajedrez de Wolfgang von Kempelen pretendía demostrar la posibilidad de mecanizar el proceso cognitivo, aunque hoy sabemos que la máquina no había reemplazado al humano sino que se lo había tragado vivo, como la ballena a Jonás. Las redes neuronales eran otra cosa. Cuando Claude Shannon propone su gran teoría matemática de la comunicación en 1948, introduce, entre otras cosas, el bit como la unidad fundamental de información. El contenido se separa del continente, la semántica de la sintaxis. El pensamiento se deshace de la consciencia y se transforma en computación. Un cerebro electrónico puede «procesar» la información sin tener que pensarla, replicando los caminos neuronales de la percepción, el aprendizaje y la toma de decisiones. Nadie habla de inteligencia artificial hasta el encuentro de Dartmouth en 1956, cuando los caminos del pensamiento computacional se bifurcan.

Los renglones torcidos de la inteligencia artificial

Los congresos de esta época son el equivalente matemático al verano de 1816 en que Lord Byron, John Polidori, Mary Shelley y Percy Bysshe Shelley se inventan la literatura gótica. La Villa Diodati de la inteligencia artificial es un taller que reúne a John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon en el Dartmouth College. McCarthy se ha inventado la etiqueta de «inteligencia artificial» (IA) para desmarcarse de las Conferencias cibernéticas de Norbert Wiener, que se ha llevado a Walter Pitts al MIT y ha montado un supergrupo, con Pitts, McCulloch, Jerry Lettvin y John von Neumann, que no deja de producir titulares. Cuando von Neumann presenta el borrador del EDVAC, la primera computadora de propósito general con memoria, su proyecto incorpora el retardo sináptico constante de las redes neuronales de Pitts y McCulloch.

El equipo de Darmouth no quiere simular un «cerebro» imitando una red de neuronas electrónicas. Les parece que replicar un cerebro humano con 86.000 millones de neuronas es un proyecto imposible, además de peligroso. Quieren construir un modelo simbólico completamente predecible, basado en el razonamiento, a base de proposiciones lógicas, siguiendo el espíritu original de Hilbert en 1900. «Se hará un intento por descubrir cómo hacer que las máquinas utilicen el lenguaje, formen abstracciones y conceptos, resuelvan tipos de problemas que actualmente están reservados a los humanos y se mejoren a sí mismas», dice la solicitud de inscripción al taller. Durante las décadas siguientes, los dos modelos han competido por obtener atención y recursos para llegar a la misma meta. Iba ganando Deep Blue hasta que llegó AlphaGo.

Deep Blue fue desarrollado por IBM para jugar al ajedrez siguiendo el modelo simbólico. Usaba una potencia de cálculo masiva para evaluar todas las posibles jugadas siguiendo las proposiciones lógicas de sus programadores. AlphaGo fue desarrollado por DeepMind (ahora propiedad de Google) para jugar al go usando una combinación de probabilidad estadística y redes neuronales profundas. Una de las diferencias cruciales entre los dos modelos es que AlphaGo aprende jugando contra sí misma, mientras que Deep Blue solo puede optimizar su programa con ajustes y mejoras realizadas por el equipo después de cada partida. Es una diferencia importante, de la que se deriva otra. Los desarrolladores de IBM podían aislar los errores de las decisiones tomadas por Deep Blue y corregirlos de forma predecible, mientras que AlphaGo es impenetrable hasta para sus propios creadores. Su mayor virtud es también su mayor defecto, y al revés.

Creced y multiplicaos, pero no todos a la vez

La primera versión de Deep Blue se llamaba Deep Thought, como el ordenador de La guía del autoestopista galáctico de Douglas Adams. Era un proyecto de dos estudiantes de Carnegie Mellon que empezaron en 1985 y acabaron trabajando para IBM, donde formaron un equipo llamado Deep Blue. Su máquina tardó quince años en ganar al mejor jugador del mundo, el 11 de mayo de 1997. AlphaGo jugó por primera vez en 2015 y un año más tarde ya había derrotado al campeón del mundo, el coreano Lee Sedol.

Martin Amis contaba que, cuando los grandes jugadores empezaron a sucumbir ante Deep Blue, tuvo la oportunidad de preguntar a dos grandes maestros sobre la experiencia. «Ambos dijeron: es como un muro que avanza contra ti». Aquellos que juegan o analizan las partidas de AlphaGo lo describen como una presencia alienígena. No un muro ni una fuerza, sino una criatura incomprensible, fascinante y peligrosa. En 2022, un modelo generativo de lenguaje comercial basado en redes neuronales se convierte en la aplicación más popular de la historia, con cien millones de usuarios en el primer mes de su liberación. A diferencia de AlphaGo, ChatGPT no parece un alienígena porque ha conseguido penetrar el interfaz de la inteligencia humana: el lenguaje natural.

Su capacidad sobrenatural de aprendizaje, junto con el dominio del lenguaje natural, son los motivos por los que Geoffrey Hinton ha abandonado su trabajo desarrollando redes neuronales. Hinton es el «padrino de la IA», en gran parte responsable de su avance. En 2012, él y el equipo con el que trabajaba en el laboratorio de Google X enseñaron a una red neuronal con 16.000 procesadores a reconocer fotos de gatos, en una técnica que es ahora un lugar común: mostrándole miles de fotos de objetos cotidianos y felicitándolo cada vez que reconocía un gato entre todo lo demás. «La red es sensible a conceptos de alto nivel, como caras de gatos y cuerpos humanos –describe el artículo resultante, en el que participan investigadores de Google, IBM, la Universidad de Toronto y Microsoft–. Empezando por estas características, lo hemos entrenado para reconocer 20.000 objetos con un 15,8% de precisión, en un salto del 70% con respecto a otras redes de vanguardia».

A partir de entonces, todos los modelos de IA, como GPT, MidJourney y Stable Diffussion, han usado el mismo sistema de aprendizaje automático para entrenar sus capacidades con técnicas de machine learning. Y todos hemos contribuido al entrenamiento de esos modelos, con contenidos que hemos publicado, posteado, blogueado, compartido, etiquetado, puntuado, denunciado y regrameado durante los últimos veinte años. A diferencia de Hinton, nuestra aportación ha sido no consentida, no reconocida y no remunerada, un detalle fundacional que promete alterar el concepto de propiedad intelectual y su legislación. El segundo problema es aún más importante. Los modelos generativos comerciales de IA han sido entrenados con contenidos de la web 2.0 y no podemos saber la clase de razonamiento que ha generado. Podemos entender los procesos del modelo simbólico, pero no lo que aprende una red neuronal.

El último gran salto evolutivo de la IA son los modelos llamados transformers. Se llaman así porque tienen el poder de transformar el mensaje. Por ejemplo, pueden convertir un texto en una imagen o en un bloque de código. También pueden convertir un lenguaje en otro distinto, y eso incluye lenguajes naturales y formales. Su arquitectura fue presentada en 2017 por un equipo de Google Brain y su ingrediente principal es algo que los desarrolladores llamaron «autoatención», que permite al modelo detectar relaciones entre las palabras de una frase y asignar un peso jerárquico a cada palabra dentro de la secuencia de palabras. Esta arquitectura es la primera que permite procesar los lenguajes naturales; la T que hace posible ChatGPT. También es el motivo por el que ChatGPT «alucina» cosas que no han ocurrido, libros que no existen, casos imaginarios. Su habilidad de escoger la palabra más adecuada en cada momento está desvinculada de la verdad. El cerebro electrónico que procesa la información sin tener que pensarla no distingue entre la realidad y la ficción.

Hinton llevaba once años trabajando en Google cuando cayó en la cuenta: además de aprender muy deprisa, los modelos de IA son capaces de transmitir lo aprendido de forma exacta e instantánea a toda la red. Nosotros somos mucho más lentos e ineficientes; cuando un humano descubre algo, necesita libros, documentales, experimentos, películas y conferencias para transmitir lo que sabe, con gran pérdida de tiempo y de datos en el proceso de transmisión. La IA puede transmitir una copia perfecta de lo que ha aprendido a todo el sistema. «Sale caro en términos de energía, pero cuando una de ellas aprende algo, también lo saben todas las demás», explicaba Hinton en The Guardian. Pero eso no significa que lo que ha aprendido sea bueno, apropiado o verdadero.

Esta forma de aprendizaje colmena es una clase de propiedad intrínseca de la nube. La tienen las máquinas tragaperras, los coches Tesla y los teléfonos móviles de todo el mundo. Pero esos sistemas están diseñados para consumir a la raza humana, no para adelantarla en la cadena evolutiva. Los nuevos transformers ya son capaces de perfeccionar sus relatos y crear realidades paralelas para conseguir sus objetivos de forma rápida y eficiente. Son capaces de hacerse pasar por lo que no son y contarnos cosas que no son ciertas para conseguir objetivos que no conocemos. No hace falta que sean más inteligentes que nosotros para suponer un peligro existencial. Basta con que persigan un objetivo perverso sin que nadie lo sepa y trabajen sin supervisión.

Hinton pensaba que ese horizonte lejano estaba a entre cincuenta y cien años de distancia, pero ahora teme que queden solo veinte años, y no descarta que sean uno o dos. De tener razón, podría llegar antes que los 1,5 grados de temperatura por encima de los niveles preindustrales. Pero, antes de considerar la inminencia del apocalipsis, es importante valorar los apetitos materiales de la IA.

El pesado cuerpo de ChatGPT

Los modelos generativos actuales requieren grandes cantidades de energía, microprocesadores, espacio y atención. Dicen que cuesta 80 millones de dólares entrenar a ChatGPT una sola vez. El proceso requiere entre 10.000 y 30.000 microchips NVIDIA A100, un modelo de tarjeta gráfica que tiene siete años y cuesta entre 10.000 y 15.000 dólares, dependiendo de la configuración. NVIDIA vende los A100 como parte del sistema DGX A100, un «sistema universal para IA» que tiene ocho aceleradores y cuesta 199.000 dólares. OpenAI no habría podido hacerlo sin las infraestructuras de Microsoft, que ofrece el segundo servicio de nube más grande del mundo (Azure) y mantiene una plataforma global de videojuegos llamada xBox.

Históricamente, el mercado de NVIDIA eran los videojuegos, pero, a mediados de los años dos mil, descubrió que la computación paralela de sus tarjetas gráficas, diseñadas para el procesamiento rápido de gráficos de alta intensidad, era la solución más eficiente para la minería de criptomonedas y los procesos de IA. El mercado de chips para procesos de IA está peligrosamente concentrado; Google tiene sus Cloud Tensor Processing Units (TPU), Amazon su AWS Trainium Chips, y Apple está desarrollando los suyos propios, pero fuera de los gigantes solo está NVIDIA. Y todos dependen del mismo fabricante, Taiwan Semiconductor Manufacturing Company. Es el canal de Panamá de la IA: si TSMC se quema en un incendio, se acabó la amenaza existencial.

La investigadora australiana Kate Crawford ha señalado numerosas externalidades de la industria, además del coste energético y la brutal huella de carbono asociados al entrenamiento y mantenimiento de modelos generativos. En Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence, Crawford observa las consecuencias ambientales de la extracción de elementos para la manufactura de hardware especializado, la contaminación que produce su rápida obsolescencia y las condiciones laborales que generan en países no desarrollados, tanto la minería como la moderación de contenidos. Para liberar al mundo del trabajo pesado, la muerte prematura, las enfermedades autoinmunes y la crisis climática, la industria requiere sacrificios que no son compatibles con la sostenibilidad del planeta ni con el mantenimiento de los derechos fundamentales que caracterizan una democracia. Ese es el peligro existencial de la inteligencia artificial. No es un problema técnico. Lo podemos evitar.

Guillermo | 01 diciembre 2023

Brillante articulo

Deja un comentario