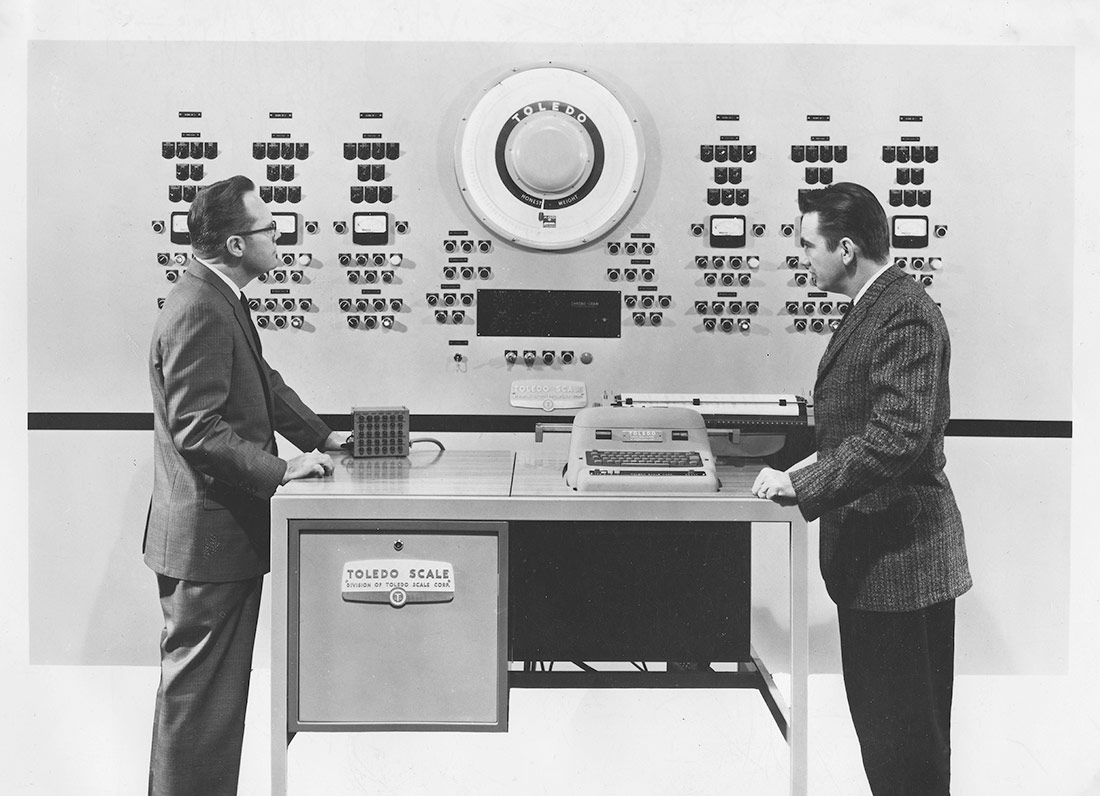

Ordinador electrònic per al control numèric d’un procés industrial | Okänd, Tekniska museet | Domini públic

La manera com concebem què és una intel·ligència artificial i com la dissenyem té greus implicacions socials. Marta Peirano revisa els orígens i l’evolució de les IA i n’encara els problemes i els perills en aquest article, que forma part del catàleg de l’exposició «IA: Intel·ligència artificial».

El Segon Congrés Internacional de Matemàtiques, que es va celebrar a París el 1900, va ser el marc on David Hilbert va presentar la famosa llista de vint-i-tres problemes matemàtics pendents de resoldre’s. Hilbert era professor a la Universitat de Gottingen i una estrella del rock de l’escena europea. A més d’haver escrit l’obra Fonaments de la geometria i d’haver fet diverses contribucions a la lògica, era el líder carismàtic de la tribu fonamentalista, amb un credo que establia el següent: si la matemàtica no és més que la manipulació de símbols mitjançant unes regles predeterminades, qualsevol problema, per complicat que sigui, té solució. Això, sempre que sapiguem traduir tots els problemes a regles i símbols calculables. Aleshores, aquest esperit era revolucionari. Ara, hauria de resultar-nos familiar.

«Qui d’entre nosaltres no estaria content d’aixecar el vel rere el qual s’amaga el futur; d’observar el desenvolupament que adoptarà la nostra ciència i els secrets d’aquest desenvolupament al llarg dels segles que vindran?», va declamar Hilbert a la conferència de la Sorbona. «Cap a quin objectiu tendirà l’esperit de les generacions futures de matemàtics? Quins nous mètodes, quins fets revelarà aquest nou segle, en el vast i ric camp del pensament matemàtic?» El 1931, un lògic austríac que es deia Kurt Gödel va demostrar que, de fet, tot sistema matemàtic prou complex contenia paradoxes irresolubles i que, per tant, la matemàtica no era capaç de demostrar-se a si mateixa tota sola, ni era l’eina definitiva per trobar la veritat. La conversa entre l’un i l’altre conforma el llegat científic del segle XX i assenyala l’inici de la generació que va parir la bomba atòmica, la revolució informàtica i la intel·ligència artificial (IA).

Quan, el 1936, Alan Turing va obrir el camí de la computació moderna, estava justament abordant un dels problemes de Hilbert. Concretament, l’Entscheidungsproblem o «problema de la decisió». Turing és molt jove i molt ambiciós i l’Entscheidungsproblem no és un problema qualsevol. Hilbert diu que és el problema més important que queda per resoldre de tota la lògica matemàtica. Té a veure amb la consistència dels sistemes lògics formals i planteja si pot existir un algorisme capaç de determinar la veritat o la falsedat de qualsevol proposició. L’article, titulat «Sobre els nombres computables, amb una aplicació a l’Entscheidungsproblem», proposa un dispositiu hipotètic capaç de realitzar càlculs i manipular símbols seguint un conjunt de regles predeterminades. Una màquina capaç d’implementar qualsevol algorisme i decidir, d’acord amb aquest conjunt de premisses o regles establertes, si una sentència matemàtica qualsevol és vàlida o no.

Amb l’ajuda d’aquest dispositiu imaginari, Turing aconsegueix demostrar les limitacions de la computació mecànica i que hi ha problemes indecidibles, com ja havia anticipat Kurt Gödel. Al mateix temps, el seu article estableix les bases d’una nova era de la computació. Hi ha molta gent que considera que la Màquina de Turing, que té una cinta per emmagatzemar dades i programes i un capçal que es mou al llarg de la cinta, processant-ne els continguts segons les instruccions d’un algorisme de programació, és el primer model conceptual d’Unitat Central de Processament (CPU). Ara mateix, per a nosaltres el més important és que va inspirar «A logical calculus of the ideas immanent in nervous activity», l’article en què Warren McCulloch i Walter Pitts proposen el primer model matemàtic d’una xarxa neuronal artificial.

Xarxes Neuronals, 1943

McCulloch i Pitts són la típica parella científica cinematogràfica: McCulloch és un filòsof vividor i quarantí que ha buscat el secret de la ment humana en les matemàtiques, la teologia, la medicina i la psiquiatria. Pitts és un nen prodigi, traumatitzat pel maltractament, que vol controlar el món amb una lògica d’enunciats ben tranquil·litzadora. La guspira entre ells salta de seguida, tots dos menyspreen profundament Freud. McCulloch s’emporta el geni vagabund a viure a casa seva i, allà, es proposen reivindicar Leibniz, l’home que, volent codificar tot el pensament humà en un llenguatge formal, ho va anticipar tot. El nou codi de McCulloch i Pitts ha de ser capaç d’expressar conceptes matemàtics, científics i metafísics, perquè siguin processats per un sistema de càlcul lògic universal. En el procés d’intentar-ho, s’inventen una cosa que anomenen xarxa neuronal.

«A logical calculus of the ideas immanent in nervous activity», publicat el 1943, presenta un model de computació basat en un sistema de nodes que s’encenen i s’apaguen d’acord amb unes regles predeterminades. El model està clarament inspirat en el treball de Santiago Ramón y Cajal, el premi Nobel navarrès que havia dibuixat les neurones com una xarxa d’unitats físicament separades que s’exciten les unes a les altres per mitjà de connexions sinàptiques. Però l’acció es basa en la màquina de Turing, que és capaç de decidir la validesa o invalidesa d’un teorema, consultant una taula de valors preconfigurada que té a dins.

La neurona electrònica de McCulloch i Pitts té dos estats, activat o inactiu, i aquests depenen del nombre d’excitacions o inhibicions que la neurona rep de les que té al voltant. En altres paraules, és relacional. Hi ha un llindar mínim de senyals capaç d’activar una neurona, i aquestes codifiquen la variació numèrica dels senyals com les operacions fonamentals de la lògica: la conjunció («i»), la disjunció («o») i la negació («no»). La resposta és activa o inactiva; veritable o fals; sí o no.

Alguns dels autòmats més famosos dels segles XVIII i XIX s’havien dissenyat per demostrar els processos de la nostra anatomia que la medicina no havia pogut observar en acció, perquè no existien ni la respiració assistida ni la refrigeració. L’ànec de Jacques Vaucanson, que menjava gra i deixava un eloqüent caminet de residus al seu pas, demostrava el sistema digestiu. El Flautista, aspirant i bufant per interpretar la seva cançó, imitava el sistema respiratori. El Turc jugador d’escacs de Wolfgang von Kempelen pretenia demostrar la possibilitat de mecanitzar el procés cognitiu, tot i que avui sabem que la màquina no havia pas reemplaçat l’humà, sinó que se l’havia empassat viu, com la balena a Jonàs. Les xarxes neuronals eren una altra cosa. Quan, el 1948, Claude Shannon proposa la seva gran teoria matemàtica de la comunicació, introdueix entre altres coses el bit com a unitat fonamental d’informació. El contingut se separa del continent, la semàntica de la sintaxi. El pensament es desprèn de la consciència i es transforma en computació. Un cervell electrònic pot «processar» la informació sense haver de pensar-la, replicant els camins neuronals de la percepció, l’aprenentatge i la presa de decisions. Ningú no parla encara d’intel·ligència artificial, fins a la trobada de Dartmouth, del 1956, quan els camins del pensament computacional es bifurquen.

Les ratlles tortes de la intel·ligència artificial

Els congressos d’aquesta època són l’equivalent matemàtic de l’estiu del 1816, en què Lord Byron, John Polidori, Mary Shelley i Percy Bysshe Shelley s’inventen la literatura gòtica. La Vila Diodati de la intel·ligència artificial és un taller d’estiu del Dartmouth college, al qual assisteixen John McCarthy, Marvin Minsky, Nathaniel Rochester i Claude Shannon. McCarthy s’ha inventat l’etiqueta «intel·ligència artificial» per desmarcar-se de les Conferències Cibernètiques de Norbert Wiener, el qual s’ha emportat Walter Pitts al MIT i ha muntat un supergrup, amb Pitts, McCulloch, Jerry Lettvin i John von Neumann, que no deixa de generar titulars. Quan von Neumann presenta l’esborrany de l’EDVAC, la primera computadora de propòsit general amb memòria, el seu projecte porta incorporat el retard sinàptic constant de les xarxes neuronals de Pitts i McCulloch.

L’equip de Darmouth no vol imitar una xarxa de neurones electròniques per simular un «cervell». Els sembla que replicar un cervell humà amb vuitanta-sis mil milions de neurones és un projecte impossible, a més de perillós. D’acord amb l’esperit original de Hilbert el 1900, volen construir un model simbòlic completament predictible, basat en el raonament, que parteixi de proposicions lògiques. «Intentarem trobar la manera d’aconseguir que les màquines facin servir el llenguatge, formin abstraccions i conceptes, resolguin problemes de la mena que actualment només les persones saben resoldre i es millorin a si mateixes», diu la presentació del taller adreçada a diverses institucions candidates a finançar-lo. Durant les dècades següents, aquests dos models han competit per rebre atenció i recursos, amb vista a la mateixa meta. Guanyava Deep Blue fins que va arribar AlphaGo.

Deep Blue va ser desenvolupat per IBM per jugar a escacs seguint el model simbòlic. Usava una potència de càlcul massiva per avaluar totes les possibles jugades seguint les proposicions lògiques dels seus programadors. AlphaGo va ser desenvolupat per DeepMind (ara propietat de Google) per jugar al go, fent servir una combinació de probabilitat estadística i xarxes neuronals profundes. Una de les diferències crucials entre els dos models és que AlphaGo aprèn jugant contra si mateix, mentre que Deep Blue només pot optimitzar el seu programa amb ajustos i millores que porti a terme l’equip, després de cada partida. És una diferència important, de la qual, se’n deriva una altra. Els desenvolupadors d’IBM podien aïllar els errors en les decisions que prenia Deep Blue i corregir-los d’una manera predictible, mentre que AlphaGo és impenetrable per als seus propis creadors i tot. La seva virtut més gran és també el seu defecte més gran, i a l’inrevés.

Creixeu i multipliqueu-vos, però no pas tots alhora

La primera versió de Deep Blue es deia Deep Thought, com l’ordinador de La Guia galàctica per a autoestopistes de Douglas Adams. Era un projecte de dos estudiants de Carnegie Mellon, que van començar el 1985 i van acabar mentre treballaven a IBM, on van formar un equip anomenat Deep Blue. La màquina que van fer va trigar quinze anys a guanyar al millor jugador del món, l’11 de maig del 1997. AlphaGo va jugar per primera vegada el 2015 i, un any després, ja havia derrotat el campió del món, el coreà Lee Sedol.

Martin Amis explicava que, quan els grans jugadors d’escacs van començar a sucumbir davant Deep Blue, ell va tenir l’oportunitat de preguntar a dos grans mestres com ho havien viscut. Tots dos van dir: «és com un mur que avança contra tu». Aquells que juguen amb AlphaGo o que n’analitzen les partides el descriuen com una presencia alienígena. No pas com un mur ni com una força, sinó una criatura incomprensible, fascinant i perillosa. El 2022, un model generatiu de llenguatge, en format comercial, que es basa en xarxes neuronals es converteix en l’aplicació més popular de la història, amb cent milions d’usuaris el primer mes d’haver-se fet públic. A diferència d’AlphaGo, el ChatGPT no sembla un alienígena, perquè ha aconseguit penetrar la interfície de la intel·ligència humana: el llenguatge natural.

La capacitat sobrenatural d’aprenentatge del ChatGPT, juntament amb el domini que té del llenguatge natural són els trets del sistema que han fet que Geoffrey Hinton –el «padrí de la IA», de la qual n’és en bona mesura responsable– hagi deixat de desenvolupar xarxes neuronals. El 2012, ell i el seu equip del laboratori de Google X van ensenyar a una xarxa neuronal amb 16.000 processadors a reconèixer fotos de gats, seguint una tècnica que ara és molt habitual: li van mostrar milers de fotos d’objectes quotidians i el van felicitar cada vegada que reconeixia un gat, d’entre tota la resta. «La xarxa és sensible a conceptes d’alt nivell com ara cares de gats i cossos humans», descriu l’article resultant del projecte, en el qual participen investigadors de Google, IBM, la Universitat de Toronto i Microsoft. «Partint d’aquestes característiques, l’hem entrenat perquè reconegui 20.000 objectes amb un 15,8% de precisió, un salt del 70% respecte d’altres xarxes d’avantguarda». D’aleshores ençà, tots els models com GPT, MidJourney i Stable Diffusion han fet servir el mateix sistema d’aprenentatge automàtic per entrenar les capacitats respectives amb tècniques d’aprenentatge automàtic (machine learning). I tots hem contribuït a entrenar aquests models amb continguts que hem publicat en xarxes socials, en blogs, o que hem compartit, etiquetat, puntuat, denunciat i reordenat, durant els últims vint anys. A diferència de la de Hinton, la nostra aportació no ha sigut consentida, ni reconeguda, ni remunerada, un detall fundacional que augura alterar el concepte de propietat intel·lectual i la legislació que la regula. El segon problema és encara més important. Els models generatius comercials d’IA han estat entrenats amb continguts de la Web 2.0. i no podem saber la mena de raonament que s’ha generat. Podem entendre els processos del model simbòlic, però no el que aprèn una xarxa neuronal.

L’últim gran salt evolutiu de la IA són els models anomenats transformers. En diuen així, perquè tenen el poder de transformar el missatge. Per exemple, poden convertir un text en una imatge o en un bloc de codi. També poden transformar un llenguatge d’una mena en un d’una altra mena, incloent-hi els llenguatges naturals i formals. L’arquitectura d’aquests models la va presentar, el 2017, un equip de Google Brain i té com a ingredient principal el que els desenvolupadors van anomenar autoatenció. Aquest tret permet que el model detecti relacions entre les paraules d’una frase i assignar un cert pes jeràrquic a cada una de les paraules que conformen una seqüència de paraules. Aquesta arquitectura és la primera que permet processar els llenguatges naturals; la «T» que fa possible el ChatGPT. Aquest també és el motiu pel qual el ChatGPT «al·lucina» coses que no han ocorregut, llibres que no existeixen, casos imaginaris. L’habilitat que té de triar la paraula més adequada a cada moment està desvinculada de la veritat. El cervell electrònic que processa la informació sense haver-la de pensar no distingeix entre la realitat i la ficció.

Hinton feia onze anys que treballava a Google, quan es va adonar d’una cosa: a més d’aprendre molt de pressa, els models d’IA són capaços de transmetre el que han après d’una manera exacta i instantània a tota la xarxa. Nosaltres som molt més lents i ineficients; quan un humà descobreix alguna cosa, necessita llibres, documentals, experiments, pel·lícules i conferències per transmetre el que sap i, en el procés de transmissió, es perden molt temps i moltes dades. La IA pot transmetre una còpia perfecta del que ha après a tot el sistema. «Surt car en termes d’energia però, quan una IA aprèn alguna cosa, també ho saben totes les altres», explicava a The Guardian. Però això no vol dir que el que ha après sigui bo, adequat ni veritat.

Aquesta forma d’aprenentatge «en rusc» (hive learning) és una característica intrínseca del Núvol. La tenen les màquines escurabutxaques, els cotxes Tesla i els telèfons mòbils de tot el món. Però aquests sistemes estan dissenyats per consumir la humanitat, no per passar-li al davant en la cadena evolutiva. Els nous transformers ja són capaços de perfeccionar els relats que emeten i de crear realitats paral·leles per aconseguir els seus objectius de manera ràpida i eficient. Són capaços de fer-se passar pel que no són i d’explicar-nos coses que no són certes per aconseguir objectius que no coneixem. No cal que siguin més intel·ligents que nosaltres, perquè comportin un perill existencial. N’hi ha prou que persegueixin un objectiu pervers, sense que ho sàpiga ningú, i treballin sense supervisió.

Hinton creia que a aquest horitzó llunyà encara trigaríem cinquanta o cent anys a arribar-hi, però ara té por en calguin només vint i no descarta que en siguin un o dos. Si tingués raó, hi podríem arribar abans d’assolir l’augment d’1,5 graus de temperatura, respecte dels nivells preindustrals. Però, abans de considerar la imminència de l’apocalipsi, és important que valorem els apetits materials de la IA.

El cos pesant del ChatGPT

Els models generatius actuals requereixen grans quantitats d’energia, de microprocessadors, d’espai i d’atenció. Diuen que costa 80 milions de dòlars entrenar el ChatGPT una sola vegada. El procés requereix entre 10.000 i 30.000 microxips Nvidia A100, un model de targeta gràfica que té set anys i costa entre 10.000 i 15.000 dòlars, depenent de la configuració. Nvidia ven els A100 com a part del sistema DGX A100, un «sistema universal per a IA» que té vuit acceleradors i costa 199.000 dòlars. OpenAI no hauria pogut fer tot això sense les infraestructures de Microsoft, que ofereix el segon servei de Núvol més gran del món (Azure) i manté una plataforma global de videojocs anomenada xBox.

Històricament, el mercat de Nvidia eren els videojocs però, a mitjan 2000, l’empresa va descobrir que la computació paral·lela de les seves targetes gràfiques, dissenyades per al processament ràpid de gràfics d’alta intensitat, era la solució més eficient per a la mineria de criptomonedes i els processos d’IA. El mercat de xips per a processos d’IA està perillosament concentrat; Google té les seves unitats de processament de tensors al núvol (TPU), Amazon els seus xips AWS Trainium i Apple està desenvolupant els seus, però fora dels gegants només hi ha Nvidia. I tots depenen del mateix fabricant, la Taiwan Semiconductor Manufacturing Company. Aquest és el Canal de Panamà de la IA: si la TSMC es crema en un incendi, s’acaba l’amenaça existencial.

La investigadora australiana Kate Crawford ha assenyalat nombrosos efectes externs d’aquesta indústria, a més del cost energètic i la petjada de carboni brutal vinculats a l’entrenament i al manteniment dels models generatius. A Atlas of AI: Power, politics, and the planetary costs of Artificial Intelligence, Crawford observa les conseqüències ambientals de l’extracció dels elements que serveixen per manufacturar maquinari especialitzat, la contaminació que produeix el fet que tinguin una obsolescència tan ràpida i les condicions laborals que la mineria la moderació de continguts generen en països no desenvolupats. Per alliberar el món del treball pesat, la mort prematura, les malalties autoimmunes i la crisi climàtica, aquesta indústria requereix sacrificis que no són compatibles amb la sostenibilitat del planeta ni amb el manteniment dels drets fonamentals que caracteritzen una democràcia. Aquest és el perill existencial de la intel·ligència artificial. No és un problema tècnic. El podem evitar.

Guillermo | 01 desembre 2023

Brillante articulo

Deixa un comentari