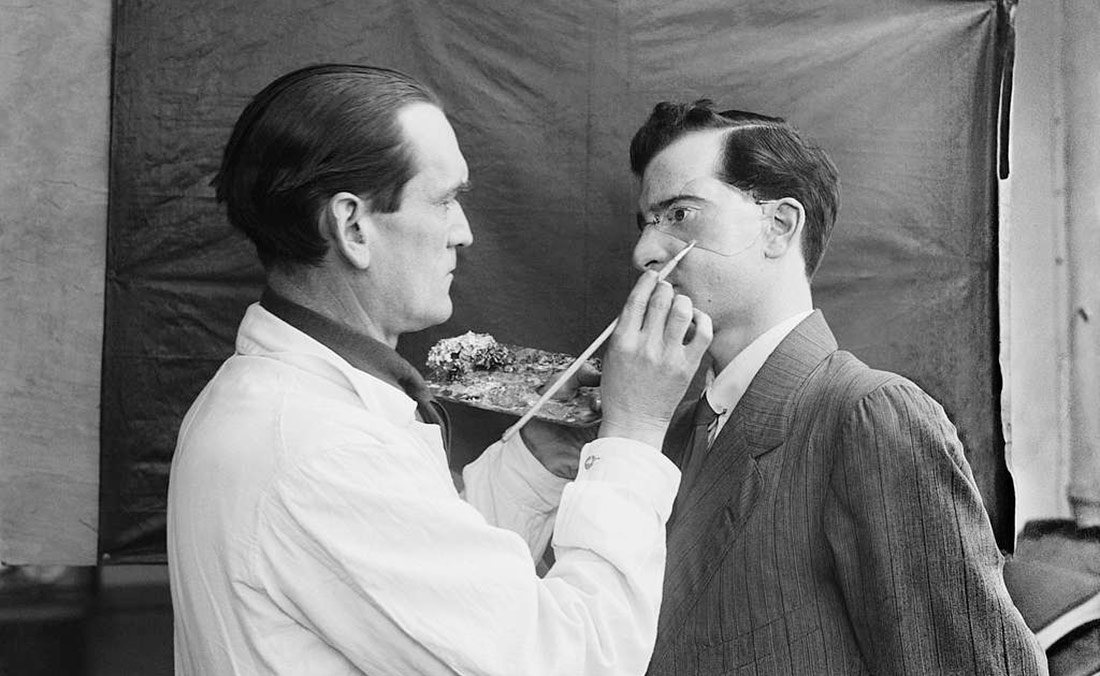

El desarrollo de la cirugía plástica reconstructiva durante la Primera Guerra Mundial | Horace Nicholls | © Imperial War Museums

El rostro es una parte del cuerpo importante para la vida personal, social e incluso institucional. Quienquiera que controle la tecnología de reconocimiento facial goza de un poder que amenaza muchos derechos y libertades. Así pues, la oposición a estos sistemas ha crecido en los últimos años, generando un debate público sobre la necesidad de regularlos.

A finales de 2021, los aeropuertos de Madrid y Barcelona iniciaron las pruebas de un sistema de reconocimiento facial que permite facturar, pasar los controles de seguridad y subir al avión sin necesidad de mostrar ni DNI ni tarjeta de embarque. El sistema –anunciaban algunos medios con entusiasmo– es tan preciso que identifica los rostros incluso con mascarilla. La influencia del marketing corporativo en el tratamiento de la noticia evidenciaba aquello que Henry David Thoreau criticaba de sus contemporáneos: «hay algunos que si les ataran a un poste de flagelación y no tuvieran libre más que una mano, la usarían para tocar las campanas y disparar cañones celebrando su libertad».

A nadie se le escapa que la tecnología de reconocimiento facial es una herramienta polémica por naturaleza, dada su capacidad de automatizar el control de la población a una escala y velocidad antes inimaginables. Su uso se extiende tanto por iniciativa pública como privada, abanderado por Gobiernos autoritarios como el de China y por grandes empresas como Apple, Mastercard o Facebook, que desde hace años han incluido sistemas de este tipo en funciones de seguridad o etiquetado de fotografías.

Del laboratorio al archivo

Si bien la tecnología de reconocimiento facial es relativamente nueva, sus implicaciones filosóficas y políticas se remontan a siglos atrás. Previos a la era digital existieron distintos esfuerzos que trataron de convertir el rostro humano en un objeto del que extraer información de manera sistemática. El más antiguo fue la fisiognomía, cuyos primeros empeños datan de la Grecia clásica, aunque se desarrolló especialmente en la segunda mitad del siglo XVIII. Esta disciplina pretendía extraer conclusiones sobre el carácter y la personalidad a partir de las formas y expresiones de la cara. También a finales de ese siglo y a principios del XIX nació la frenología, que entendía que la forma del cráneo es un reflejo del cerebro y que era posible estudiarla para predecir conductas como la inclinación al matrimonio, la poesía y la bondad; pero también al robo y el crimen, por poner algunos ejemplos.

Pero si una disciplina enlaza de manera directa con la tecnología de reconocimiento facial contemporánea es la del archivo policial. El primer sistema de fichas de identificación de criminales aparece en Francia en 1833 y, en las décadas posteriores, otras sociedades industriales se interesan por analizar el crimen a escala regional. Como señala el teórico de la imagen Hans Belting, «las autoridades querían protegerse de la amenaza sin rostro que suponían los delincuentes, sobre los que habían perdido el control en las grandes ciudades; por eso desarrollaron febrilmente métodos apropiados de control facial». De esa necesidad surgió el proyecto de crear un archivo de rostros, con la fotografía como herramienta que permitía garantizar la fiabilidad de ese inventario. El objetivo era tener un censo de todas las personas anónimas que se diluían en la masa, y la urgencia se acrecentó con revueltas como la de la Comuna de París, cuando las autoridades iniciaron una ola de represión que trascendía a los delincuentes comunes para abarcar a aquellas personas condenadas por insurrecciones políticas.

Sin embargo, todas estas disciplinas mostraron pronto sus limitaciones. El propio Alphonse Bertillon, el artífice de la policía científica, reconocía en 1885 que la fotografía no era una herramienta fiable para identificar criminales. Como los arrestos sucedían en lugares y épocas diferentes y los retratos los tomaban policías distintos, las imágenes estaban sujetas a demasiados cambios como para garantizar su veracidad.

Una tecnología excluyente

Los problemas de las técnicas de control del siglo XIX se resolvieron, paradójicamente, cuando dejó de ser necesario observar. La tecnología de reconocimiento facial extrae referencias de los rasgos de la cara y comprueba si están presentes o no en una base de datos. Esto significa que, aun usando como materia prima las imágenes, la máquina no las interpreta, sino que se limita a convertirlas en información.

Este tratamiento carente de una mirada humana que interprete y entienda el contexto ha dado lugar a errores ampliamente conocidos y denunciados. El aprendizaje automático funciona buscando patrones en el mundo real, pero para hacerlo previamente ha usado «datos de entrenamiento», que en muchos casos reflejan y perpetúan los sesgos de las personas que los han facilitado. Un estudio ya clásico del MIT y Stanford demostró en 2018 que el margen de error de los sistemas de reconocimiento facial era mayor en mujeres que en hombres y, más aún, en personas negras que en blancas. En una elocuente demostración del problema, la investigadora afroamericana Joy Buolamwini señaló que algunos algoritmos no reconocían su rostro pero sí una máscara blanca de plástico sin ninguna expresión.

Aunque algunas empresas han tratado de corregir estos sesgos, el problema tiene difícil solución, especialmente en la vertiente predictiva de algunos algoritmos. Al abordar el carácter discriminatorio de sus sistemas, los centros de investigación han hallado que la justicia y la equidad son conceptos ambiguos y difícilmente traducibles en fórmulas matemáticas, por lo que no siempre es fácil programar software que garantice la ecuanimidad.

El arte del camuflaje

La amenaza que el reconocimiento facial supone para algunos derechos ha generado preocupación en muchos colectivos activistas, pero también en artistas que a lo largo de la última década han buscado formas de sortear esta tecnología. Entre los pioneros, el más prolífico es Adam Harvey, que centra su trabajo en la investigación y la crítica de la vigilancia. Hace una década, este estadounidense afincado en Berlín ganó cierta notoriedad con CV Dazzle, un proyecto en torno a la moda como herramienta para sortear los mecanismos de detección de rostros. El concepto se basa en el uso de maquillaje y otros elementos como cortes de pelo asimétricos que, convenientemente elaborados, confunden a los algoritmos e impiden su funcionamiento.

Desde 2010, la iniciativa se ha ramificado en otros conceptos como Stealth Wear, una colección inspirada en la vestimenta islámica tradicional y en el uso de drones como arma de guerra, y que emplea tela reflectante para evitar la localización de sistemas de vigilancia térmica. Otro proyecto relacionado es HyperFace, un patrón en fase de prototipo que, en lugar de confundir al algoritmo negándole la posibilidad de reconocer el rostro, le proporciona caras falsas para saciar su necesidad de identificar.

Con un enfoque distinto, el artista Zach Blas estudia las consecuencias de esta tecnología en los colectivos que sufren una mayor desigualdad y en los que no responden a los cánones normativos a nivel cultural. Uno de sus proyectos más notorios es Facial Weaponization Suite, que consiste en la elaboración de «máscaras colectivas» a partir de datos faciales agregados de personas que forman parte de grupos excluidos. Fag Face Mask, por ejemplo, se generó a partir de las imágenes de hombres queer, pero se elaboraron objetos similares para representar la invisibilización de la mujer, la criminalización de los hombres negros o la vigilancia fronteriza entre México y Estados Unidos. Las caretas resultantes tratan de representar esas identidades en una única cabeza amorfa que los algoritmos no pueden identificar.

Otro proyecto de Blas relacionado con colectivos discriminados es Face Cages, en el que el artista trabaja a partir de los diagramas geométricos que generan los softwares de identificación facial. El proyecto reúne a cuatro artistas queer para que generen gráficos biométricos de sus propios rostros, que luego se fabrican como objetos metálicos tridimensionales. Una vez puestas, las caretas recuerdan a jaulas o barrotes, o evocan algún tipo de tortura medieval. En el entorno museístico, la obra se muestra con vídeos de los propios artistas portando esa suerte de armadura en la cara, pero su vocación es performativa, por lo que también se usa en acciones y representaciones públicas.

Una tercera aproximación que vale la pena mencionar es la del estadounidense Sterling Crispin, que entre 2013 y 2015 desarrolló Data Masks, una obra que no pretende anular el reconocimiento facial sino reflejarlo. El proyecto se basa en la ingeniería inversa, haciendo que los propios algoritmos creen formas parecidas a rostros. De los resultados de ese proceso, el artista produce una serie de máscaras impresas en 3D que califica como «sombras de seres humanos vistas por el ojo de la mente de la máquina-organismo». Como se detalla en la documentación del proyecto, el objetivo de las caretas no es confundir al algoritmo, sino mostrarle un espejo, de modo que la máquina trabaje en base a sus propias reglas y convenciones.

En la obra de estos tres artistas existe un nexo común: el objetivo de las máscaras no es esconderse de la cámara, sino confundirla, engañarla. En este sentido sus trabajos pueden entenderse como herramientas reivindicativas, armas de guerra. Esta característica las asemeja con el camuflaje, una táctica militar –a menudo desarrollada en colaboración con artistas– que no siempre busca la desaparición del sujeto, sino que también pretende dificultar la observación al enemigo. Un ejemplo clásico es la pintura de barcos dazzle que se empleó durante la I Guerra Mundial para decorar naves con líneas chillonas y formas de estilo cubista, lo que desconcertaba a la flota rival, que no podía adivinar el tamaño ni la dirección de las embarcaciones. Del mismo modo, las obras de Harvey, Blas y Crispin no pretenden la desaparición de sus portadores. Pensadas para su uso público en manifestaciones, su función es la de hacer visible y llamativa su denuncia de las formas dominantes de vigilancia y control.

Un movimiento anti-reconocimiento facial

En 2014 el periodista Joseph Cox escribía que «un movimiento anti-reconocimiento facial está creciendo». Echando la vista atrás, tal vez fuese prematuro hablar de «movimiento», pero hay que reconocer que los experimentos de diseño crítico en torno a esta materia no han dejado de aumentar. Algunos proyectos siguen la estela del trabajo con máscaras, pero las técnicas ya abarcan, entre otros ejemplos, piezas de joyería, camisetas, proyectores de rostros, gafas con luces LED, pasamontañas pixelados o pañuelos con caras estampadas.

Ninguna de estas técnicas de camuflaje es siempre efectiva. De hecho, algunas de ellas sirven solo para algoritmos concretos o para versiones de software que existían años atrás. Por otro lado, caminar con la cara cubierta o con artilugios extravagantes no parece cómodo ni elegante, por lo que la investigación sobre cómo frustrar la tecnología de reconocimiento facial todavía tiene terreno que explorar. En cualquier caso, las iniciativas de estos artistas y activistas sirven para alertar y despertar interés en la ciudadanía, lo que acaba teniendo una repercusión en el debate público y legislativo. Ya son muchos los gobiernos, tanto a nivel local como estatal, que proponen regular estos algoritmos en distintas partes del mundo. El destino de estas decisiones sumará otro peso en la siempre frágil balanza entre seguridad y libertad.

Deja un comentario