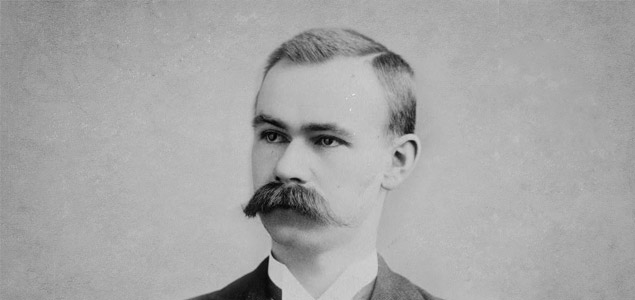

Herman Hollerith (1860-1929), inventor de una máquina basada en tarjetas perforadas para procesar rápidamente millones de datos. Fundador de la Tabulating Machine Co., de la que surgió posteriormente IBM. Fuente: Library of Congress.

En la última década se han establecido, al menos en la percepción colectiva, varias verdades fundamentales sobre el estado de la información como materia prima y su papel en el mundo. A saber:

- La cantidad de datos que somos capaces de producir, transmitir y almacenar crece a un ritmo que no tiene precedente.

- Dado que cada vez resulta más barato y sencillo almacenarlos, merece la pena almacenarlos por principio.

- En estos volúmenes de información se encuentran grandes bolsas de conocimiento valioso que puede ser extraído. Eso sí, siempre que seamos capaces de «leerlo», lo que resulta cada vez más complejo a medida que su volumen aumenta. Tener más datos obliga a desarrollar nuevas formas de interpretarlos.

- La extrema facilidad con la que las organizaciones producen datos hoy se ve contrarrestada por la ansiedad que genera la posibilidad de que estén dejando escapar el valor que hay enterrado en ellos, de no ser capaces de filtrar la paja y extraer hasta el último grano.

Instituciones científicas, empresariales y gubernamentales han desplegado una amplia infraestructura tecnológica para capturar y almacenar tantos datos sobre cada fase de sus procesos como sea posible. Se ha invertido en nuevos campos de conocimiento –la nueva ciencia de los datos– y en profesiones emergentes: del data scientist al analista de datos y el experto en visualización de la información. Pero la realidad es que, en lo que se refiere al control de la información que producen, la mayoría de grandes organizaciones viven permanentemente desbordadas. En palabras de un mando militar estadounidense, «estamos nadando en sensores y ahogándonos en datos».

Esta condición es característica de la era del diluvio de datos.

La idea de que vivimos en la onda expansiva de una gran explosión de información no es estrictamente nueva. La percepción de que la cantidad de datos que somos capaces de producir no deja de incrementarse hasta llegar a volúmenes inmanejables aparece a la vez que la informática se convierte en una industria real implementada en cada vez más procesos administrativos. El primer uso registrado de la expresión information explosion aparece en 1961 en una publicación académica, y prácticamente a la vez en un anuncio de IBM en el New York Times. Su equivalente contemporáneo, algo menos dramático pero igualmente efectista, es el «diluvio» o «tsunami» de datos, términos que se vuelven comunes entre la comunidad académica y la prensa económica a mediados de la década pasada.

Hay varias maneras de expresar el vértigo que produce la explosión de datos, y la más técnica es probablemente la llamada ley de Kryder. Si la famosa ley de Moore ha predicho durante varias décadas de manera más o menos correcta la velocidad a la que progresa la capacidad de procesamiento de los ordenadores –el doble cada 18 meses–, la ley de Kryder intenta expresar con precisión el ritmo al que aumenta nuestra capacidad de almacenar cada vez más información digital en un espacio determinado.

En 2014, esta fotografía es probablemente una forma más efectiva de entender el tamaño de la ola y el cariz del diluvio. Hace cincuenta años, un disco duro era un enorme dispositivo del volumen de un utilitario pequeño, cuya memoria era capaz de almacenar el equivalente a una canción en formato MP3; una ridícula porción de la capacidad de almacenamiento de ese teléfono que llevamos en el bolsillo del pantalón o en el bolso de mano.

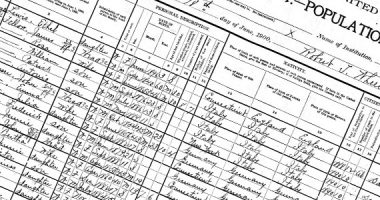

El viaje desde la cinta de papel y las tarjetas perforadas –los primeros formatos de almacenamiento informático en los años cuarenta del siglo xx– hacia los soportes de hoy como los lápices USB o las minitarjetas SD, es otra representación de la ley de Kryder muy elocuente. En la tensión entre un contenedor que se reduce y a la vez se expande infinitamente en su capacidad de almacenar contenido encontramos la mejor expresión de este vértigo.

A medida que nuestra experiencia personal y nuestra biografía se codifican en estos soportes magnéticos, ópticos o rígidos, el problema de su preservación a largo plazo se convierte en más urgente. Si nuestra historia colectiva está preservada en los miles de data centers que hemos esparcido por todo el globo, su función puede pasar de ser meramente operativa a ser archivística. Y, sin embargo, carecemos de toda estrategia real sobre cómo mantendremos toda esa información accesible y utilizable en el futuro. Acuerdos como el que permite a la Biblioteca del Congreso americana almacenar una copia del flujo de mensajes de Twitter parecen garantizar que conservaremos algunos archivos importantes, pero cada vez que muere una Startup o un servicio es comprado por un gigante de Internet para acabar languideciendo, los datos que produjo y que preservaban pueden desaparecer para siempre, instantáneamente, sin dejar rastro.

La más importante de las nuevas instituciones archivísticas es probablemente el Internet Archive de Brewster Kahle. Desde 1996, el Internet Archive rastrea y «fotografía» metódicamente la web, para preservar instantáneas de cómo era Internet en un día cualquiera de un año concreto, luchando contra su carácter dúctil y constantemente inestable. Esta hermosa película de Jonathan Minard revela la infraestructura física que, en una iglesia desacralizada de San Francisco, hace posible su funcionamiento. Recientemente, un incendio puso en peligro su valioso legado; afortunadamente, solo afectó a las instalaciones en que se digitalizan libros impresos.

De momento, el diluvio de datos no ofrece ninguna señal de amainar, y es probable que la ley de Kryder siga su progresión. Quizá el siguiente paso, el siguiente salto de magnitud, se encuentre en el soporte que utiliza la naturaleza para almacenar sus datos.

En el Instituto Europeo de Bioinformática de Cambridge –el mayor almacén de secuencias genómicas del continente–, se almacena información digital muy sensible y que es esencial conservar accesible durante muchas décadas. Los discos duros, que hay que reemplazar periódicamente y que hay que mantener refrigerados, distan de ser el soporte idóneo para preservar este código de la vida. Son, de hecho, una tecnología mucho peor que el propio ADN.

La paradoja no le ha pasado por alto al zoólogo y matemático Nick Goldman, uno de los «bibliotecarios de la vida» encargado de mantener las bases de datos del EBI: mientras que nuestros soportes informáticos son frágiles, ocupan espacio y son difíciles de mantener, el ADN puede almacenar una gran cantidad de información en poquísimo espacio, durante millones de años. En enero de 2013, Goldman y su equipo anunciaron que habían conseguido transferir 739 modestos kilobytes de datos a una cadena de ADN. Posteriormente, un ordenador consiguió decodificarlos y leer sus contenidos: los 154 sonetos de Shakespeare, un artículo académico, una foto del laboratorio de los investigadores, 26 segundos del más célebre discurso de Martin Luther King y un algoritmo de software. Es solo un comienzo, pero en el EBI tienen grandes metas para la técnica que han desarrollado: su objetivo a largo plazo es conseguir almacenar el equivalente de un millón de CD en un gramo de ADN, con una longevidad mínima de diez mil años.

Deja un comentario