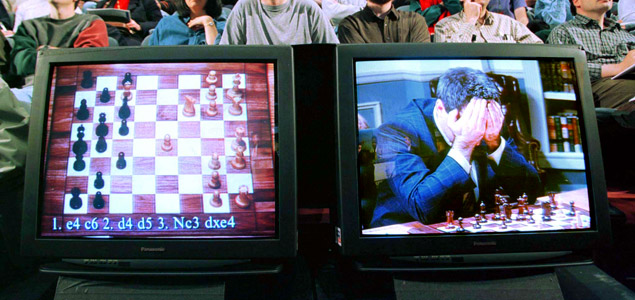

La victòria de Deep Blue sobre Kasparov el 1977.

La clave de la angustia en las buenas historias de zombies (Night of the Living Dead, Dead Set, Dawn of the Dead…) es, en el fondo, la inevitabilidad de su desenlace. En ellas, el carácter irrevocable y exponencial de la propagación del zombie en el pulso por la repartición del pastel demográfico se presenta casi siempre como un triunfo de la estupidez (encarnada en el zombie) por encima de la inteligencia (representada por el homo sapiens). La epidemia zombie parece aberrante, porque significa la destrucción de la ilustración, la erradicación de la civilización, el fin del rasgo diferencial que supuestamente define a la humanidad. Parece totalmente irrelevante que, en una taxonomía alternativa de los mamíferos, el zombie cinematográfico sea probablemente nuestro pariente más próximo. Nos separan tan solo una alteración de las constantes vitales y una discrepancia en el aparato perceptivo/analítico que habitualmente denominamos inteligencia. Precisamente por su proximidad a nuestra fisiología, en la filosofía de la mente, el zombie (no el cinematográfico, sino una variación puramente hipotética) se utiliza a menudo como punto de partida en varios argumentos contra el fisicalismo, la doctrina según la cual todo cuanto existe es exclusivamente físico. Y no importa si los zombies filosóficos y los cinematográficos no habitan en nuestro entorno diario: son un buen punto de partida para examinar desde dentro y de cerca nuestras concepciones de inteligencia, de conciencia y de subjetividad. Al fin y al cabo, y a pesar de su ubicuidad, «inteligencia» es una de las palabras más difusas de nuestro vocabulario, con muchas definiciones que se adaptan a múltiples posibles aplicaciones del término.

Uno de los usos más comunes de la palabra fuera del radio de acción humano, y al mismo tiempo uno de los más polémicos, es el de inteligencia artificial. Casi sesenta años después de su acuñación original por parte de John McCarthy en 1955, la IA sigue siendo un territorio con tantas lecturas, que se hace difícil pensar en un punto de encuentro entre detractores y defensores, o incluso entre extremos opuestos de la comunidad, del triunfalismo naif de Ray Kurzweil al pesimismo de Hubert Dreyfus. Hace relativamente poco tiempo, el propio McCarthy intentaba resumir al mínimo el marco de la disciplina como «la ciencia y la ingeniería de construir máquinas inteligentes». Pero incluso las definiciones más simples y menos ambiciosas chocan con la trampa que oculta el título, el propio término inteligencia. ¿Cómo definimos con precisión un concepto que solo entendemos superficialmente? ¿Cómo evitamos el peligro que Daniel Dennett denomina el «mal de la definición prematura»? Ante la pregunta previa «¿qué es, pues, la inteligencia?», McCarthy contestaba que es «la parte computacional de la habilidad de alcanzar objetivos». Y, a pesar de que esta es solo una de las decenas de definiciones concebibles (existen muchas más, formuladas desde la biología, la filosofía o la psicología), la respuesta, como otras muchas, abre la puerta a consideraciones que trascienden de lejos el campo del homo sapiens.

Plantas, microorganismos, colectivos

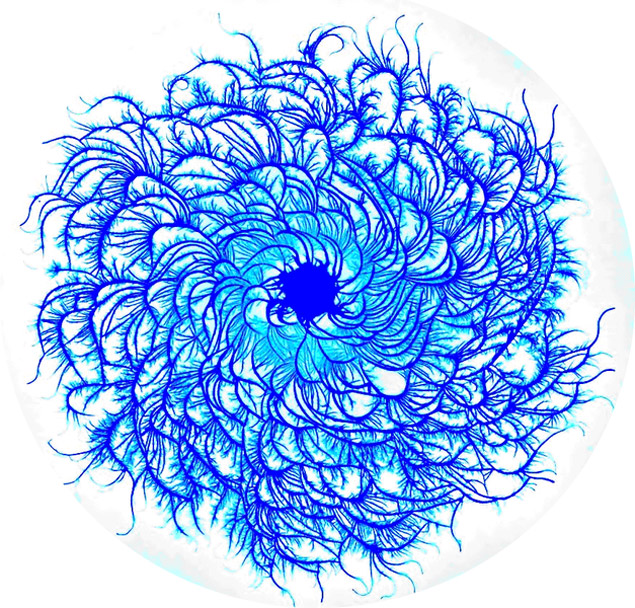

Varios investigadores defienden desde hace años la noción de inteligencia vegetal, que Anthony Trewavas (de la Universidad de Edimburgo) describe como «la propiedad emergente resultante de las interacciones colectivas entre los diferentes tejidos de una planta individual en crecimiento». En su reciente y fascinante What a Plant Knows: A Field Guide to the Senses, otro defensor notable de la idea, Daniel Chamovitz (de la Universidad de Tel Aviv), añade: «a pesar de que podríamos definir subjetivamente la inteligencia vegetal como una faceta más de la multiplicidad de inteligencias, esta definición no nos ayuda a ampliar nuestro conocimiento ni de la propia inteligencia, ni de la biología de las plantas. En mi opinión, la cuestión no debería ser si las plantas son inteligentes o no. Va a pasar mucho tiempo antes de que lleguemos a un acuerdo sobre lo que eso significa en el fondo; la pregunta más bien debería ser “¿Son conscientes, las plantas?” y, de hecho, lo son». De nuevo, la noción de conciencia que promulgan Chamovitz y Trewavas tiene poco que ver con la de nuestra especie. De entrada, porque parte de una anatomía radicalmente distinta de la de los mamíferos. La conciencia humana tiene como mínimo algo que ver con las redes neuronales del cerebro y, a pesar de que las plantas no tienen neuronas, sus redes de células se comunican de forma similar. El neocórtex humano, la parte del cerebro que se ocupa de tareas como la percepción sensorial y espacial, las órdenes motoras o el lenguaje, entre otras, es diferente de las redes celulares de los organismos vegetales, pero, igual que estas, es un sistema de memoria que permite crear un modelo para formular predicciones y actuar en consecuencia. Dejando de lado las diferencias estructurales, si una condición esencial de lo que denominamos comportamiento inteligente es la capacidad de prever el futuro, identificando patrones del entorno para adaptarse al mismo y optimizar el coste energético, las plantas e incluso las bacterias muy primitivas encajan cómodamente en esta categoría, según los estudios publicados por Roger Bingham y Peggy La Cerra a finales de los noventa. Recientemente, varios equipos de investigadores en el campo de la microbiología han empezado a hablar de inteligencia bacteriana, destacando la capacidad comunicativa y organizativa de bacterias «sociales» como la especie Paenibacillus dendritiformis.

Paenibacillus dendritiformis.

Jeff Hawkins, fundador del Redwood Center for Theoretical Neuroscience (y de Palm Computing, para los nostálgicos de la tecnología de consumo) insiste en que, partiendo de una observación detallada de la fisiología del neocórtex, puede elaborarse una breve lista de las características y condiciones esenciales para la inteligencia, que posteriormente podemos extrapolar a cualquier otro sistema, no necesariamente humano. Ni siquiera necesariamente biológico. De hecho, Hawkins no es el único en afirmar que algunos rasgos que durante siglos se habían aceptado como condiciones sine qua non del comportamiento inteligente, como el lenguaje, no forman parte de esta lista de atributos fundamentales. En 2001, partiendo de la famosa cita de Wittgenstein «si un león pudiera hablar, no le entenderíamos», el compositor electroacústico, activista e investigador en el campo de la ecología David Dunn reflexionaba en «Nature, Sound Art and the Sacred» sobre la supremacía sensocéntrica que la humanidad ha impuesto tradicionalmente sobre el mundo no humano. Para Dunn, una de las semillas del problema es el convencimiento de que, dado que los animales no hacen uso de un lenguaje como el humano, son poco más que máquinas orgánicas para ser explotadas. «Estudios recientes demuestran que el lenguaje en términos humanos no es una condición indispensable para el pensamiento y que, de hecho, cada forma de vida podría ser consciente a su manera. La vida y la cognición podrían considerarse sinónimos incluso a nivel celular». Desde la Grecia clásica, el concepto de animal racional ha servido de frontera arbitraria para separar al homo economicus de los demás miembros del reino animal, aunque, en un sentido literal, racionalidad significa poco más que la capacidad de tomar decisiones óptimas para alcanzar objetivos. Y ello, de nuevo, se ajusta a la gran mayoría de formas de vida conocidas.

Contemplar la infinidad del universo o concebir artefactos como un motor a reacción requieren capacidades que quizá no tienen otras especies del planeta, pero no olvidemos que estos hitos son más fruto de la inteligencia acumulada de la especie que de cada uno de nuestros aparatos perceptivos/analíticos de modo individual. Redes de individuos, más que de neuronas. Thomas W. Malone, director y fundador del MIT Center for Collective Intelligence, dedica buena parte de su labor docente y de investigación al estudio de la inteligencia colectiva, que él define a grandes rasgos como «grupos de individuos funcionando colectivamente de formas que parecen inteligentes», una noción de comportamiento que funciona como un espejo en dos direcciones, humano-no-humano. Malone dice: «los grupos de hormigas son probablemente más inteligentes que las hormigas a nivel individual, y del mismo modo podemos entender a los grupos humanos y sus artefactos computacionales y de otros tipos como colectivamente inteligentes. Esta perspectiva no solo plantea cuestiones profundas e interesantes desde el punto de vista de la ciencia, sino que también lanza preguntas filosóficas acerca de la condición colectiva de los humanos, por encima de la individualidad». Cercano a la idea de la inteligencia colectiva, pero desde un terreno neutro entre la computación, la neurociencia y la filosofía, el matemático y experto en inteligencia artificial Marvin Minsky defiende desde hace años lo que él denomina la Teoría de la Sociedad de la Mente. Una propuesta reminiscente de las ideas de Latour que explica la mente humana y la de otros sistemas cognitivos naturales como una gran sociedad hecha de procesos individuales, denominados «agentes», las entidades pensantes fundamentales a partir de las que se construye la mente.

El xenomorfo y el posthumano

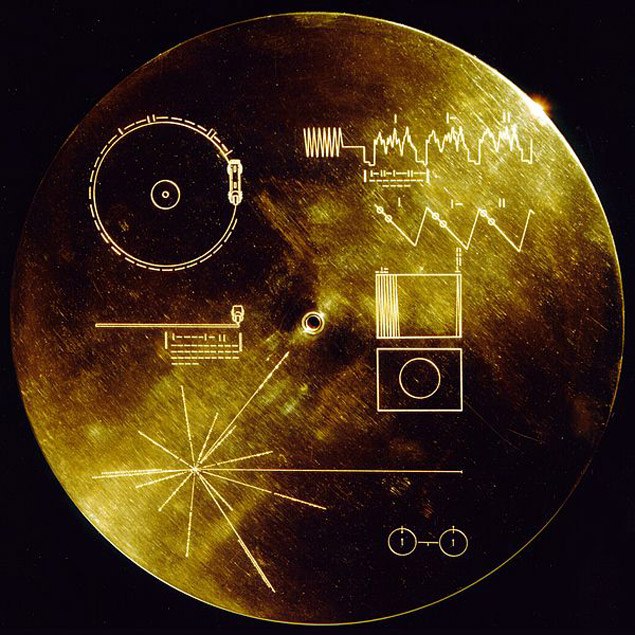

Sin embargo, el antropocentrismo rampante que desde tiempos inmemoriales ha dictado las concepciones de inteligencia que aún predominan en la cultura occidental no se limita a la vida en nuestro planeta. Buena parte de los esfuerzos para la investigación de vida inteligente fuera de la Tierra, por ejemplo, se basan en el objetivo de hallar seres, especies, civilizaciones similares al homo sapiens. Y pocos artefactos humanos representan mejor esa mezcla de prepotencia y estupidez como el icónico disco de oro de las sondas Voyager lanzadas al espacio en 1977. El disco, fruto del trabajo de un comité presidido por Carl Sagan, contiene una selección de imágenes y sonidos con la misión de mostrar a formas de vida extraterrestres la biodiversidad y pluralidad cultural de la Tierra. Afortunadamente, va acompañado de un mensaje de Jimmy Carter explicando la buena intención del proyecto y de instrucciones de reproducción detalladas, que incluyen (en aritmética binaria) el tiempo correcto de rotación del plato en unidades de tiempo de 0,7 billonésimas de segundo (el periodo de tiempo asociado a la transición fundamental del átomo de hidrógeno). Es decir, que más allá del hecho de que el Voyager 1 tardará cerca de 40.000 años en llegar relativamente cerca –1,6 años luz– de la estrella Gliese 445, el proyecto confía en que esta hipotética forma de vida:

- Contará con aparatos sensoriales auditivos y visuales remotamente similares a los nuestros, para poder escuchar y ver las mismas frecuencias codificadas en el disco.

- Utilizará alguna forma de prensibilidad que les permita poner la aguja en el surco.

- Tendrá un nivel básico de inglés (para descifrar el mensaje de Carter).

- Será una civilización experta en química, en especial en el estudio del hidrógeno.

- Y en aritmética binaria.

Disco de oro de las sondas Voyager.

Asumir que las demás formas de vida inteligente del Universo son parecidas a la nuestra, y no a un delfín (gracias, como siempre, Douglas Adams), una espora o una nube de gas, es sencillamente delirante. No debería sorprendernos que el «xenomorfo» (para usar un término de ciencia-ficción con bastante carga especista), sea brutalmente distinto a cualquier criatura familiar, o que rompa conceptos cotidianos como la simetría bilateral. En Alien (1979), el único miembro de la tripulación que aprecia la «perfección» del xenomorfo es Ash, el androide del Nostromo… Sin salir de nuestro planeta, de hecho, encontramos organismos que cuestionan nuestros estereotipos sobre anatomía y los ciclos vitales. Los hongos mucilaginosos viven como entidades unicelulares hasta que la escasez de alimento les conduce a unirse en un pseudoplasmodio hecho de múltiples individuos, y los estudios realizados en las últimas décadas sobre la capacidad de orientación y la «memoria» de estos organismos sin cerebro son especialmente interesantes con relación al debate de la inteligencia.

Hongos mucilaginosos.

Lejos de la ingenuidad del disco de oro del Voyager, la cuestión del contacto posthumano se plantea de forma más interesante en el documental de Michael Madsen Into Eternity (2010). Ante la necesidad de almacenar residuos nucleares en un depósito subterráneo en Finlandia, los responsables del repositorio se preguntan de qué modo pueden alertar a las futuras generaciones, futuras civilizaciones (humanas o no), del peligro que suponen los residuos, incluso miles de años después. Una impresionante lección de psicología colectiva que intenta especular al límite mismo del pensamiento humano para anticiparse, sin éxito, a posibles interpretaciones posthumanas del mensaje. Tal y como queda implícito en el filme de Madsen, no podemos prever la interpretación de los mensajes de alerta por parte de una civilización posthumana, del mismo modo que no podemos participar de la experiencia subjetiva de otras especies de nuestro planeta. La columna vertebral del célebre artículo de Thomas Nagel «What is it like to be a bat?» (1974) sigue vigente en muchas de las reflexiones sobre «el problema difícil de la mente», el hecho de que nunca podemos eludir nuestra experiencia en primera persona. Y, a pesar de esa imposibilidad, no dudamos en ponernos en la piel de otros organismos y fijar de modo taxativo los límites de lo que consideramos comportamiento consciente, racional, inteligente. Ante este obstáculo insalvable, quizá lo mejor sería relajar totalmente estos límites, ya que nunca sabremos qué es ser o cómo se siente un murciélago, una espora o un agujero negro. Y es perfectamente posible que los murciélagos, las esporas y los agujeros negros no tengan ningún tipo de experiencia consciente, pero es imposible determinarlo. El carbonocentrismo derivado de las diferentes variantes del principio antrópico sigue bien atrincherado en nuestro subconsciente, y en el de la comunidad científica. Hasta el momento, las únicas formas de vida que conocemos son sistemas moleculares basados en carbono, pero parece algo arrogante negar con rotundidad otras posibilidades.

De Turing a la singularidad: inteligencia artificial

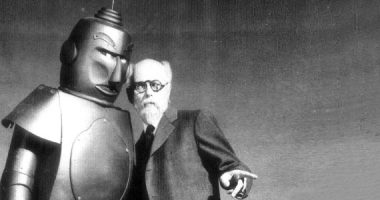

Prácticamente desde su nacimiento, la hoja de ruta de la inteligencia artificial ha estado estigmatizada por ideas relativamente alejadas de la realidad, que conforman lo que todos esperamos de una máquina inteligente. El famoso test propuesto por Alan Turing en 1950 es uno de estos regalos envenenados, no tanto por la intención inicial de su autor, que en varias ocasiones manifestó su total desinterés por el debate de si la IA era posible o no, como por la lectura que de él se ha hecho posteriormente. Juzgar la inteligencia de una máquina en base a su capacidad de emular el comportamiento humano era, para Turing, un simple criterio fenético, más que el patrón universal a seguir. Pero su célebre test de inferencia inductiva ha influenciado profundamente la percepción social de la IA. Y, a pesar de que las diferentes ramas de la investigación no parecen muy preocupadas en pasar con éxito el test de Turing, un número considerable de los proyectos de IA sigue tomando la emulación como punto de partida. En una especie de remezcla pseudocientífica del impulso creacionista y pigmaliónico tan firmemente arraigado en la cultura occidental (Golem, Pinocchio, Frankenstein, C-3PO), Lucy Suchman lista en «Human–Machine Reconfigurations» los tres componentes que ella considera indispensables para asegurar el carácter «humano» de cualquier proyecto de inteligencia artificial: corporeidad, emoción y sociabilidad. Por suerte, el grueso de la investigación en IA parece más enfocado a explorar las posibilidades de la inteligencia estrictamente maquinal para generar modelos que contribuyan a mejorar nuestro entendimiento del acto cognitivo. Como explica el belga Luc Steels, uno de los abanderados de la robótica basada en comportamiento: «existen dos motivaciones básicas para trabajar en IA. La primera es puramente pragmática. Muchos investigadores buscan algoritmos útiles para la extracción de datos o el procesamiento de imágenes, funciones con un amplio abanico de aplicaciones prácticas. La otra motivación es científica: usamos ordenadores y robots como plataformas experimentales para investigar aspectos de la inteligencia (…). Hace tiempo que la mayoría de la comunidad es consciente de que imitar la inteligencia humana no es buen camino hacia el progreso, ni para obtener aplicaciones prácticas, ni para alcanzar una comprensión más amplia de la propia inteligencia. Al igual que unos biólogos aprenden más sobre la vida estudiando una simple bacteria de E. coli, estudiar la inteligencia a partir de formas más simples puede llegar a ser de gran utilidad». Sin embargo, la IA sigue chocando con lo que desde hace años se conoce, irónicamente, como el efecto IA: la tendencia a desacreditar nuevos hitos de la disciplina bajo el pretexto de que no están basadas en comportamiento inteligente «real», sino en programas que de alguna forma lo simulan. Ni siquiera los triunfos más mediáticos de los últimos años (la victoria de Deep Blue sobre Kasparov en 1997 o la de Watson sobre los campeones absolutos de Jeopardy! en 2011), han servido para apaciguar esa negación constante. El australiano Rodney Brooks, uno de los pioneros de la robótica desde los años ochenta, hacía referencia al efecto IA en una entrevista en Wired en 2002, diciendo que una broma común entre sus colegas era que «AI» (sus siglas en inglés) significaban en realidad «almost implemented» (casi implementado).

Ampliar los límites

La negativa humana a aceptar otras inteligencias se basa principalmente en el miedo a dejar de disfrutar de un estatus privilegiado en el Universo conocido –no en vano la especie se ha autodesignado con el nombre doblemente narcisista de «homo sapiens sapiens». Romper el contrato de exclusividad humanidad-inteligencia es un gesto difícil de digerir. Pero el desconcierto también reside en el simple hecho de que muchas de las teorías citadas utilizan terminología tradicionalmente «humana» (conciencia, mente, pensar, etc.) para describir propiedades de sistemas no humanos. Drew McDermott incluso propone sustituir «inteligencia artificial» por «informática cognitiva». En cualquier caso, el antropocentrismo que marca inevitablemente nuestra experiencia choca de forma frontal con nociones radicales como el supuesto modelado predictivo que demuestran determinados microorganismos, o la teoría de la singularidad de Irving John Good, que en 1945 se atrevía a predecir la llegada de la primera máquina ultrainteligente. Ante el obstáculo, la humanidad se agarra al chovinismo de la especie y se protege bajo la dificultad real que plantea, por ejemplo, el «problema de las demás mentes», uno de los retos clásicos e insalvables de la epistemología, que pregunta: si lo único que podemos observar es el comportamiento de los demás, ¿cómo podemos saber si estos tienen mente? El interrogante funciona tanto de forma metafórica (en el caso de los zombies filosóficos) como de forma práctica (para la IA), y se plantea como un desafío monumental a la hora de admitir como válidas otras formas de inteligencia, a la hora de aceptar lo que Ian Bogost denomina fenomenología alienígena, o la posibilidad de lo que Kristian Bjørn Vester (Goodiepal) define como inteligencias alternativas (ALI), para citar los dos casos que considero más interesantes del panorama actual.

Si en algún momento debemos llegar a reconocer esa multiplicidad de inteligencias, tenemos que dejar de analizarlas a partir de nuestro propio reflejo, y prescindir de nociones con tanta carga de especie como «mente», que quizá no tienen tanto que ver con el tema como hemos asumido hasta ahora. En un artículo reciente publicado en Physical Review Letters, Alex Wissner-Gross (MIT) y Cameron Freer (Universidad de Hawaii) proponen un primer paso para explicar la relación entre inteligencia y la maximización de la entropía, que según ellos provoca una emergencia espontánea de dos comportamientos típicamente humanos (la utilización de herramientas y la cooperación social) en sistemas físicos simples. Y aquí ya no estamos hablando ni de organismos vivos como plantas, ni de colonias de termitas descentralizadas, ni de mamíferos espabilados como delfines, ni de ordenadores de presupuesto billonario como Watson. Hablamos de péndulos.

Saty Raghavachary | 05 junio 2021

Hi Roc, LOVE your article on MULTIPLICITY…

I pondered this as well, and came up with this definition of intelligence: ‘considered response’ – it covers all you mention and more – slime molds, ant colonies, plants, viruses, humans… 🙂

Here is my writeup: https://www.researchgate.net/publication/346786737_Intelligence_-_Consider_This_and_Respond

Deja un comentario