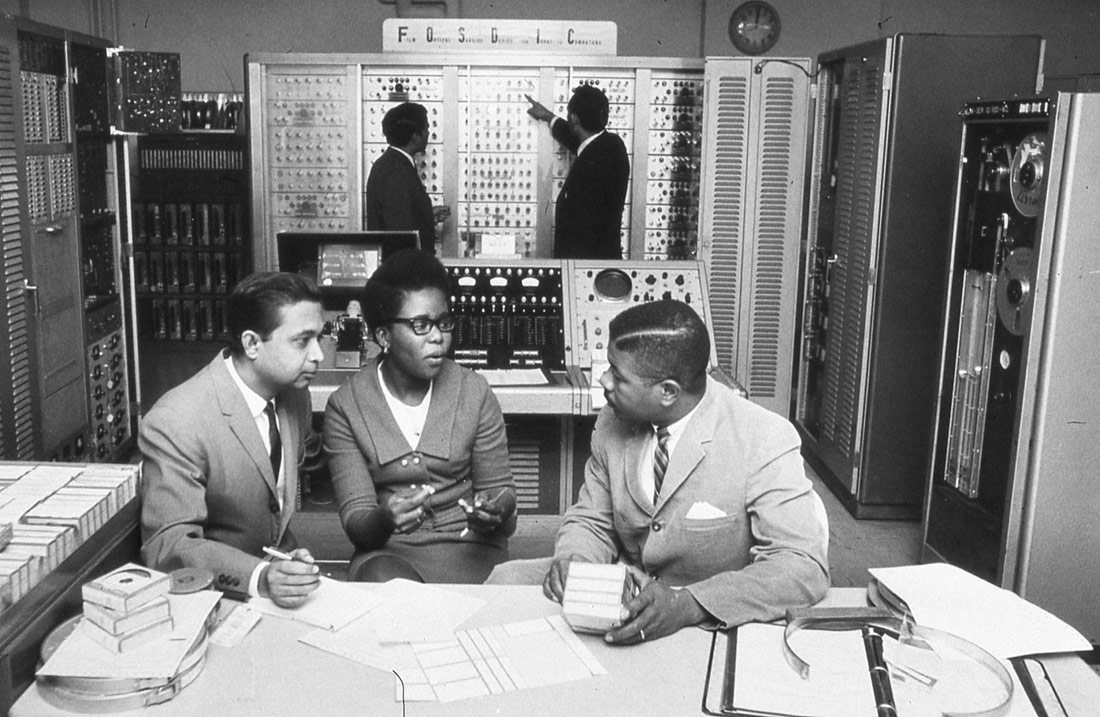

FOSDIC (Film Optical Sensing Device for Input to Computers) | U.S. Census Bureau | Domini públic

És arriscat reduir l’ètica a un càlcul matemàtic de danys i opcions possibles. Els algoritmes d’aprenentatge automàtic es valen del context per prendre decisions, sense una comprensió causal dels fenòmens que pretenen predir. El coneixement ètic humà és prereflexiu, no és només la conclusió d’un argument purament racional, sinó que és el resultat d’un procés formatiu que comença durant la infància. Es tracta d’una esfera de l’activitat humana a la qual tenim un accés immediat, de manera intuïtiva, i és el resultat de compartir natura i cultura. Aquesta intuïció de moment no és reduïble a algoritmes, ni dels que es basen en regles i definicions, ni dels que es basen en semblances estadístiques.

El jutge examina detingudament els informes que ha rebut. Després consulta les notes que ha pres i emet el veredicte: «Considerant el nom de pila, l’edat, el barri en què viu i les notes que ha tret a secundària, he decidit declarar-lo culpable del crim de què se l’acusa.»

Si un jutge dictés una sentència similar, l’escàndol seria molt gros, però la policia de Durham, al Regne Unit, utilitza un sistema d’aprenentatge automàtic conegut amb el nom de HART (Harm Assessment Risk Tool, ‘Eina per establir riscos de danys’) que serveix per fer prediccions de qui podria reincidir en el crim. El programa fa servir correlacions com el tipus de barri en què la persona viu, l’origen ètnic (obtingut a partir del proxy del nom de pila) i el grau d’absentisme escolar per detectar una possible «joventut desconnectada» que podria dur a terme crims contra la propietat o contra persones.

El problema no és el grau d’efectivitat del sistema. Encara que el programa tingués una eficàcia del 100% i encertés tots els casos, continuaria sent incompatible amb la nostra idea del que és la justícia.

En el llibre Explicació i comprensió, el filòsof G. H. V. Wright va recollir una intuïció bàsica sobre la qual descansa la nostra idea de justícia. Hi argumenta que, a l’hora de donar sentit a la vida, fem servir dos paradigmes diferents: les causes i les raons. Segons Von Wright, les causes ens expliquen per què una cosa ha succeït com ha succeït, mentre que les raons ens permeten entendre el motiu últim pel qual una cosa s’ha esdevingut. Les causes formen part del raonament científic i ens expliquen amb detall com una cosa s’esdevé. Les raons cauen dins l’esfera de les humanitats i ens expliquen el perquè d’una situació, basant-se en una comprensió humana, situada, de la manera com entenem el món i dels nostres valors.

El filòsof austríac Ludwig Wittgenstein va plantejar aquesta intuïció en un dels aforismes de les Investigacions filosòfiques, en el qual argumenta que, quan un jutge decideix que declararà culpable una persona, ho fa sempre basant-se en les raons que van menar aquesta persona a actuar. Si es guiés per les causes, en canvi, sempre la deixaria lliure. És a dir, si busquem la causa última d’un comportament criminal, sempre acabarem trobant alguna cosa: abusos durant la infantesa, malalties mentals… En darrer terme, sempre podem dir que les neurones del cervell de l’individu en qüestió havien adoptat una estructura i una formació que el van menar inevitablement a cometre un delicte. Apel·lem a les raons per les quals hom actua, i no pas a les causes, a l’hora de valorar l’eticitat d’un comportament.

Com he explicat en el primer article d’aquesta sèrie (Biaix en bucle: alimentant la injustícia algorítmica), els algoritmes actuals d’aprenentatge automàtic es basen majoritàriament en el context, i no tenen cap mena de comprensió causal dels fenòmens que intenten preveure. Si casualment totes les persones que es diuen David i que viuen en un determinat barri de Durham ja estiguessin fitxats com a criminals perillosos, i jo me n’hi anés a viure, cada dos per tres tindria la policia a casa i m’assenyalarien com a sospitós de qualsevol delicte. Fins i tot és fàcil d’imaginar que, tip de tanta pressió, en algun moment acabés cometent-ne un de debò.

Imaginem-nos ara que, en el futur, aconseguim programes d’intel·ligència artificial capaços de formular raonaments causals correctes –situació de la qual encara som molt lluny, segons diuen experts en el raonament de la IA com Judea Pearl. Tot i això, encara no tindríem una IA capaç de raonar com un jutge, perquè li faltaria conèixer les raons de les coses.

El filòsof Hubert Dreyfus, recentment traspassat, ha defensat aquesta tesi de manera coherent en diversos articles que plantegen en què consistiria un coneixement expert en ètica. Dreyfus insisteix en la idea que un mer coneixement discursiu, de causes, sobre el que és ètic i el que no, seria insuficient per copsar els raonaments ètics d’una persona.

Un equip d’investigadors del MIT fa servir el famós problema de la vagoneta, de la filòsofa contemporània Philippa Foot, per intentar ensenyar a prendre decisions ètiques als cotxes autònoms. La idea és que, davant d’un accident inevitable en què hi hagi més d’una opció, el cervell electrònic del cotxe intel·ligent prengui el determini moralment més adequat. És, doncs, un intent de reduir l’ètica a un càlcul matemàtic de danys i opcions possibles.

Aquest sistema, que sens dubte seria útil, no capta, però, tots els matisos que té una decisió humana. Bàsicament perquè el nostre coneixement ètic és prereflexiu, no és només la conclusió d’un argument purament racional, sinó que és el resultat d’un procés formatiu que comença durant la infantesa, període en què passem per una sèrie d’experiències personals que ens permeten donar sentit al món. Aquestes experiències estan molt influïdes per la societat i la cultura en què vivim. El nostre coneixement ètic és espontani, intuïtiu i immediat. No estableix veritats gravades a la pedra, sinó que és fluid i revisa i reemmarca la percepció de quan una acció és ètica o no en funció de la interacció amb altres persones i cultures. Aquest acostament es basa en la nostra capacitat bàsica de donar sentit a l’entorn, capacitat que necessita una autonomia radical que ens permeti establir-nos com a subjectes en el món.

Vegem ara un altre exemple concret. L’any 2016, Facebook va decidir retirar la fotografia icònica de l’aleshores nena de nou anys Kim Phúc, sense roba, fugint d’un atac amb napalm durant la guerra del Vietnam. Un algoritme automàtic havia classificat la imatge com a «possible pornografia» i l’havia eliminada del compte d’un periodista noruec que duia a terme una investigació sobre l’horror de la guerra. Van caldre moltes protestes del diari i fins i tot del govern noruec, a més de milers d’usuaris indignats, perquè Facebook afluixés la corda i finalment la fotografia tornés a la xarxa social.

La resposta oficial que Facebook va argüir per defensar que no tenia intenció de permetre aquella fotografia va ser que era molt complicat establir quan una imatge d’una menor sense roba era apropiada i quan no. I, certament, si el que busquem és un algoritme que ens digui si una fotografia és pornogràfica o no en funció de la quantitat de pell al descobert que mostra, no ens en sortirem. Per entendre per què l’escena de «la noia del napalm» no és pornogràfica, sinó que és una denúncia de l’horror de la guerra, necessitem entendre moltes coses sobre la naturalesa humana: què ens dona plaer i què ens fa patir, què és un soldat, què és una guerra, com se sent una criatura quan veu que cauen flames del cel. Tot això es perd si senzillament estudiem graus de similitud entre la imatge de Kim Phúc fugint i les fotografies que hom pot trobar en llocs web com Pornhub.

Potter Stewart, jutge del Tribunal Suprem dels Estats Units, va presentar el dilema de manera perfecta quan, l’any 1964, en el moment que havia de decidir si una pel·lícula era pornogràfica o no, va declarar: «Avui no intentaré descriure els tipus de materials que entenc que han d’incloure’s dins d’aquesta descripció [“pornografia hardcore”], i potser no tindria mai èxit si ho intentés fer de manera intel·ligible. Però els reconec quan els veig, i la pel·lícula involucrada en aquest cas no s’hi ajusta.» «Els reconec quan els veig» resumeix perfectament el que intento descriure en aquest article. Hi ha una esfera de l’activitat humana a la qual tenim un accés immediat, intuïtiu, que resulta de compartir una naturalesa i una cultura. Aquesta intuïció no es pot reduir a algoritmes, ni dels basats en regles i definicions ni dels basats en similituds estadístiques. Però tots la reconeixem quan la veiem.

Dreyfus creia que aquestes capacitats humanístiques estaven totalment fora de l’abast de les màquines electròniques. Jo, en canvi, em confesso agnòstic pel que fa a aquesta qüestió. No veig que hi hagi cap raó ontològica o gnoseològica per la qual algun dia no puguem arribar a tenir veritables intel·ligències artificials, que rivalitzin amb les nostres capacitats humanes, tot i que intueixo que aquest dia encara és molt llunyà.

Crec, però, que hi ha una lliçó clara que cal que considerem: el desenvolupament de les tecnologies digitals no s’ha de guiar només per criteris científics i de mercat, sinó que també ha d’incloure una visió humanística que ens informi de quan té sentit un aparell o un algoritme i quan és més adequat confiar les decisions a les intuïcions humanes.

Consuelo | 19 juny 2018

Muy interesante y clara reflexión. Gracias

Gonzalo Génova | 11 gener 2023

Un artículo excelente. Llego aquí por la referencia incluida en el trabajo de una alumna del curso “Inteligencia natural y artificial” que acabo de impartir en mi universidad (Carlos III de Madrid).

Tenemos muchos puntos en común, en mi blog he escrito mucho sobre la “moralidad algorítmica”. Por ejemplo: Conformidad con la norma (https://demaquinaseintenciones.wordpress.com/2022/09/15/conformidad-con-la-norma/) y Utilitarismo: ¿se puede calcular la felicidad? (https://demaquinaseintenciones.wordpress.com/2021/11/21/utilitarismo-se-puede-calcular-la-felicidad/).

Sobre la cuestión apuntada en el penúltimo párrafo, “No veo ninguna razón ontológica o gnoseológica por la que no podamos tener un día verdaderas inteligencias artificiales”, en mi opinión la clave para dar una respuesta negativa es esta: la pregunta no es si un ente material puede ser libre, sino si un ente DISEÑADO PARA UN FIN puede ser libre. Porque eso es la IA.

Deixa un comentari