Funambulistes a la fira del 4-H Club . Cimarron, Kansas, 1939 | Russell Lee, Library of Congress | Domini públic

Les intel·ligències digitals s’utilitzen cada cop més per resoldre qüestions complexes que abans es decidien a partir de l’experiència dels professionals. Analitzem, doncs, de quina manera prenen les decisions els humans i les màquines, i qui ho fa de manera més justa segons el context.

L’Aixa és una nena de cinc anys que arriba a Urgències d’un hospital acompanyada de la seva àvia. La menor presenta símptomes clars de maltractament i contusions per tot el cos. La dona explica a la doctora que els seus pares li han pegat. Per descobrir si hi ha risc de reincidència i evitar que la nena rebi noves pallisses, la doctora planteja preguntes sobre l’escenari dels fets: ha de decidir entre derivar-la als serveis socials perquè la protegeixin judicialment o fer-la tornar a casa, on el maltractament podria repetir-se. Per a aquest fi, disposa d’una eina d’intel·ligència artificial (IA) que estimarà la gravetat del cas i les mesures cautelars a partir de les respostes obtingudes. Si la decisió final és que cal separar-la dels pares, aquesta nit l’Aixa no tornarà a casa, passarà per centres de menors i cases tutelades, on adults desconeguts es faran càrrec de les seves necessitats bàsiques durant els propers anys i fins que arribi a la majoria d’edat.

Quan el 2018 l’escriptora i matemàtica Cathy O’Neil va visitar el CCCB per presentar-hi el llibre Weapons of Math Destruction, va llançar una pregunta al públic: «Qui seria capaç de decidir si una menor que ha patit maltractaments ha de tornar a casa seva o no, amb la intenció de protegir-la de futures agressions?». L’audiència va quedar muda, ningú no sabia què calia respondre. «Als Estats Units, hi ha un algoritme que ho decideix», va afegir. Aleshores, segur que entre el públic n’hi havia molts que es demanaven: però… com pot ser que un algoritme sàpiga que la menor rebrà una pallissa abans que passi? I, segons més tard, la mateixa O’Neil va respondre: «No ho pot saber, però ara mateix està passant.»

Fa tres anys, la pregunta podria haver sonat provocadora i llunyana, però actualment aquesta mena d’eines operen en la majoria de països sense que la població en sigui conscient. Els professionals que porten casos socials diàriament prenen decisions complexes sobre assumptes molt diversos. Abans del boom de la IA, es basaven en l’experiència pròpia acumulada durant anys.

Òbviament, de vegades s’equivocaven en les decisions que prenien, cosa que podia tenir conseqüències molt greus per a les persones afectades. Per això ara s’espera que els sistemes d’IA ens ajudin a millorar els determinis. Què passa, però, si l’eina d’IA ofereix un resultat diferent del de l’especialista? Quin preval? Si l’algoritme decideix que l’Aixa corre molt de perill i la doctora, en canvi, no considera que la situació sigui tan greu per separar la criatura del nucli familiar, aleshores la doctora s’atrevirà a enviar la nena a casa?

Sabem que la IA no és perfecta i que fins i tot el millor sistema intel·ligent comet errors. Per tant, hem de demanar-nos: quin grau de confiança es concedeix a la màquina i quina confiança es té en l’experiència del professional? Per donar resposta a aquesta pregunta, potser caldria analitzar quina de les dues decisions –la humana o la de la màquina– té més perill de biaix i més soroll (és a dir, més variància en les decisions). Això, deixant al marge la tendència humana a acceptar les recomanacions d’un sistema que considerem intel·ligent.

Diferències entre biaix i soroll

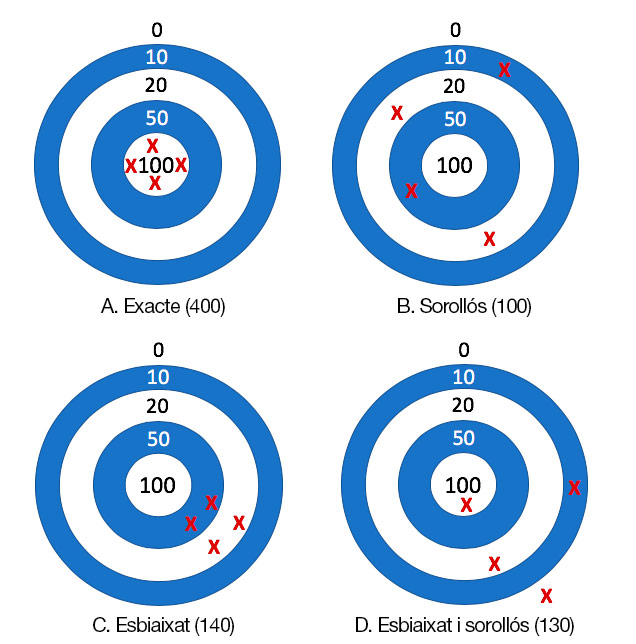

El 2016, l’economista Daniel Kahneman va escriure, junt amb altres autors, un article titulat: «Noise: How to Overcome the High, Hidden Cost of Incosistent Decision Making». Hi explicava la diferència entre «biaix» i «soroll» fent una analogia amb el resultat de llançar dards en quatre dianes. La diana A no té ni biaix ni soroll; la diana B només té soroll; la diana C, només biaix, i la diana D té totes dues coses. El diagrama següent es basa en aquesta idea.

Comencem pel principi, però: què s’entén per «biaix» i què s’entén per «soroll»? La IA és bona per establir una gran quantitat de patrons i relacions, així com per agilitzar processos i operacions amb dades massives (big data). Això no obstant, els algoritmes no són neutres, ni tampoc les dades que serveixen per entrenar-los, perquè tenen biaixos. No hi ha dubte que els algoritmes de la IA presenten biaixos, però els continuem utilitzant perquè el benefici o l’encert dels resultats és considerablement superior (en més d’un 90 %) al perjudici o a l’error. Els biaixos s’assemblen als prejudicis: tots en tenim, en major o menor grau. N’hi ha molts que els heretem de l’entorn social o familiar, sense que en siguem conscients. El biaix més gran és creure que no tenim cap prejudici. Però… alerta: si els biaixos no es corregeixen, correm el perill d’habitar un futur en el qual, a causa de la perpetuació dels prejudicis, el progrés social sigui cada cop més difícil.

D’altra banda, el concepte de «soroll» podria definir-se com les diferents decisions que es poden prendre en relació amb una acció (individual o col·lectiva) en una situació personal o professional. Quan es va demanar als desenvolupadors de programari d’una empresa que estimessin el temps que trigarien a desenvolupar una tasca determinada, les hores comptabilitzades van variar una mitjana de més del 70 %. Per què, si la tasca és la mateixa per als mateixos perfils de professionals d’una mateixa empresa? Sovint es prenen decisions que s’allunyen de les que prendrien altres col·legues, de les decisions pròpies preses anteriorment o de les que hom assegura que segueix.

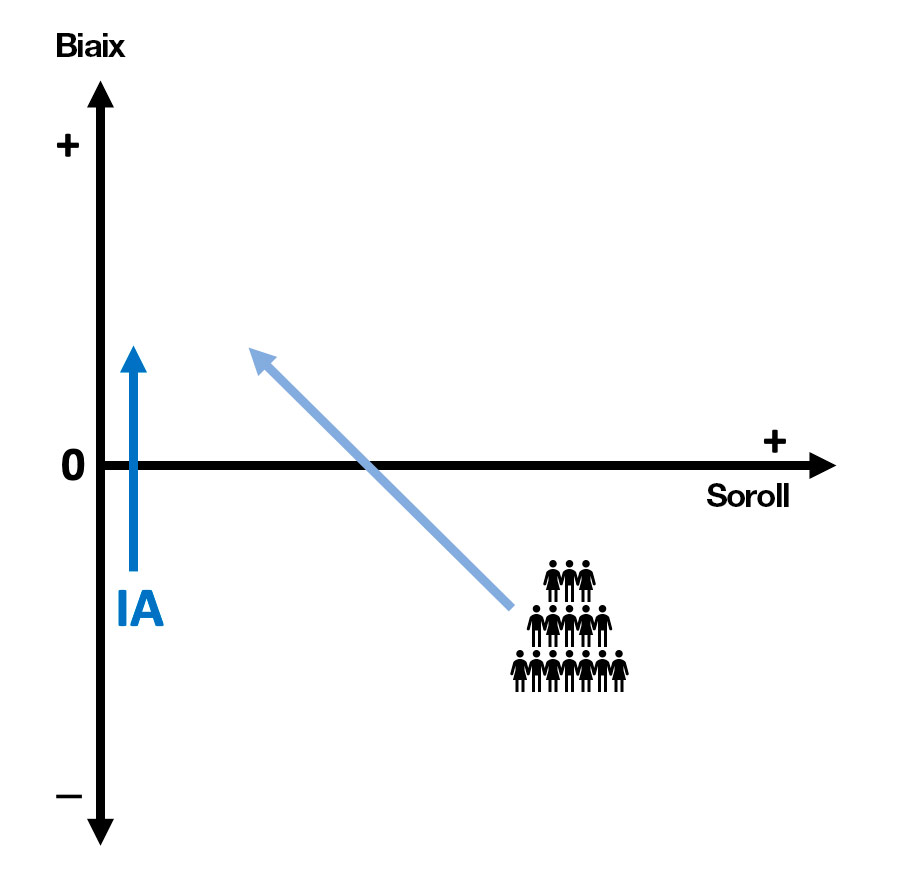

Arribats a aquest punt, convé saber que la IA té biaixos, però no té soroll. En canvi, a les persones ens influeixen totes dues variables.

El soroll és fàcil de percebre

Tornem ara a les dianes. Si les veiéssim per darrere, ens adonaríem que B i D tenen més variabilitat, i fàcilment en notaríem el soroll. Però entre A i C no és tan fàcil saber quina és la diana amb biaix. És a dir que el soroll és fàcil de percebre, en canvi, no sempre som conscients dels biaixos. La majoria de les decisions humanes tenen soroll, per això busquem una segona opinió en qüestions mèdiques o desitgem que el jutge o la jutgessa que ens assignin estigui de bon humor el dia de la nostra audiència. Aquests dos exemples il·lustren el soroll a escala individual, però nosaltres tampoc som coherents al llarg del temps.

El 2007, els investigadors de Stanford van analitzar les decisions de petició d’asil als EUA i van descobrir que mentre un jutge només n’aprovava el 5 %, un altre n’aprovava el 88 %. Tots dos tenien biaix, i cada biaix era diferent, però la totalitat del sistema judicial es mostrava sorollós, perquè les decisions dels jutges no eren coherents. Finalment, el biaix pot ser negatiu (masclisme) o neutral (paritat de gènere). Al capdavall, és una qüestió de consens social.

I en quin sentit és més justa, la IA?

Una IA sense soroll és més justa en el sentit que, davant de dos casos iguals, la previsió que fa és la mateixa. És a dir, si dos acusats cometen el mateix crim, la condemna serà la mateixa. El que passa és que ben poques vegades els casos són idèntics. El paradigma de la injustícia social amb un algoritme el va treure a la llum ProPublica –un mitjà estatunidenc independent– el 2016, després de dur a terme una investigació per demostrar el biaix que aplicava l’algoritme COMPAS en perjudici dels acusats negres.

La IA no té soroll perquè els algoritmes són deterministes. És a dir, davant d’una entrada similar, el resultat serà similar. Per exemple, un controlador aeri pot dirigir el trànsit d’avions més bé o més malament en funció de la situació d’estrès, del cansament o de les circumstàncies que n’afectin l’estat d’ànim. En canvi, un sistema intel·ligent sempre proporcionarà els mateixos resultats en una mateixa situació. Això, dels jutges, no ho podem dir.

En canvi, la IA sí que pot ser desigual, perquè aprèn a partir dels biaixos intrínsecs a les dades. A l’anàlisi «Human Decisions and Machine Predictions», el científic Jon Kleinberg –junt amb altres col·laboradors– explicava que el sistema entrenat amb dades de fiances de Nova York era racista i amplificava lleument les decisions del jutge més racista; això resultava una mica sorprenent, atès que l’única informació demogràfica que feia servir era l’edat de l’acusat. En altres paraules, el racisme estava codificat en els antecedents criminals i se’n servia per deduir-lo. Malgrat això, l’algoritme era més just, perquè no tenia soroll. Mantenint la mateixa taxa de fiances podia disminuir la criminalitat en un 25 %; mantenint el mateix grau de criminalitat, podia atorgar la fiança a un 42 % dels inculpats que abans no l’obtenien. Pitjor encara: prenent en consideració els crims comesos, els jutges concedien la fiança a més de la meitat de l’1 % dels criminals més perillosos.

Això no obstant, com diria l’ètica Lorena Jaume-Palasí, la justícia en realitat és molt més complicada. Podria donar-se el cas que, en compliment de la llei, un jutge o una jutgessa hagi deixat en llibertat algú fins i tot quan sospita que les possibilitats de reincidència criminal són elevades. «La justícia va més enllà de repetir el passat a l’hora de decidir un cas. Cal contextualitzar», explica Jaume-Palasí, «perquè, encara que els antecedents siguin semblants a altres casos, el context pot ser completament diferent. És més just qui discrimina de manera coherent però no té en compte cada cas de manera individual? Si un sistema reinterpreta el que requereix la llei, i els jutges fan servir una metodologia oposada a la requerida, això ja és injust per si sol».

Biaixos positius per a la societat

Hem d’assumir que la IA sempre tindrà biaixos? No necessàriament. És possible que un algoritme prengui decisions automatitzades sense biaix per a les persones o les empreses? Això dependrà de si els biaixos rauen en les dades, en l’algoritme o en la interacció entre l’usuari i el sistema. Com que a la pràctica és realment difícil que no n’hi hagi de cap mena, el que cal és mitigar-los. Serà difícil eliminar-los, especialment quan no coneixem totes les fonts. Els més importants són explícits, però n’hi ha molts altres que poden ser implícits.

Els biaixos també poden ser positius, cosa que vol dir que tenen un efecte favorable per a la societat. Aquesta condició hauria de ser exigible per a qualsevol algoritme que prengués decisions automatitzades o fes prediccions. Per exemple, que als hospitals hi hagi més infermeres que infermers podria ser un biaix positiu si es demostrés que elles tenen més qualitats empàtiques i d’atenció amb els pacients.

Amb el temps, seria bo que la IA ajudés a tenir biaixos positius (veg. fletxa blava vertical del diagrama adjunt), i que fos prou útil perquè les persones percebessin els biaixos propis i poguessin reduir-los (veg. fletxa diagonal del diagrama). Ara bé… Això no és demanar massa coses a aquesta tecnologia? Si som les persones les que programen la IA, i nosaltres mateixos no som conscients dels nostres biaixos, com podrem aconseguir que les màquines ho facin per nosaltres? No hauríem d’aconseguir, en primer lloc, canviar tot el nostre sistema educatiu global i aprendre a identificar els biaixos socials i cognitius ja des de petits?

Més humans amb més tecnologia

La IA desperta molts recels. Els avantatges que presenta s’exhibeixen sobradament, però també se’n coneixen els riscos per la multitud d’errors identificats en els últims anys. Entre els seus màxims reptes hi ha el de l’explicabilitat, és a dir, aconseguir entendre com aprèn de manera automàtica un algoritme i com presenta els resultats, ja sigui en forma de decisions automàtiques o de prediccions.

Un altre risc –tal com esmenta l’artista i investigadora Joana Moll a l’article «Contra la complexitat»– és que se’ns faci creure que les màquines poden resoldre qualsevol problema de manera senzilla. En aquest sentit, és inevitable demanar-se quines conseqüències podria tenir aquest laissez faire per a qualsevol societat. Si, per exemple, la doctora de l’Aixa confiés cegament en els resultats dels algoritmes que té a disposició i desterrés la seva intuïció, derivada de l’experiència professional, els humans dependríem exclusivament de les màquines per a qualsevol moviment, progrés o evolució.

Sense ànim de posar-nos apocalíptics, ni d’acabar en el pitjor escenari possible, caldria esperar que la tecnologia més avançada ens ajudés a construir un futur cada cop més respectuós amb els drets i els valors pels quals hem lluitat en les últimes dècades. El com encara és una incògnita; ni tan sols no sabem si ho aconseguirem. El que sí que podem desitjar, però, és que la IA sigui cada cop millor i que complementi el coneixement humà. De moment, però, no només no corregeix els nostres errors, sinó que en ocasions fins i tot els magnifica.

Deixa un comentari