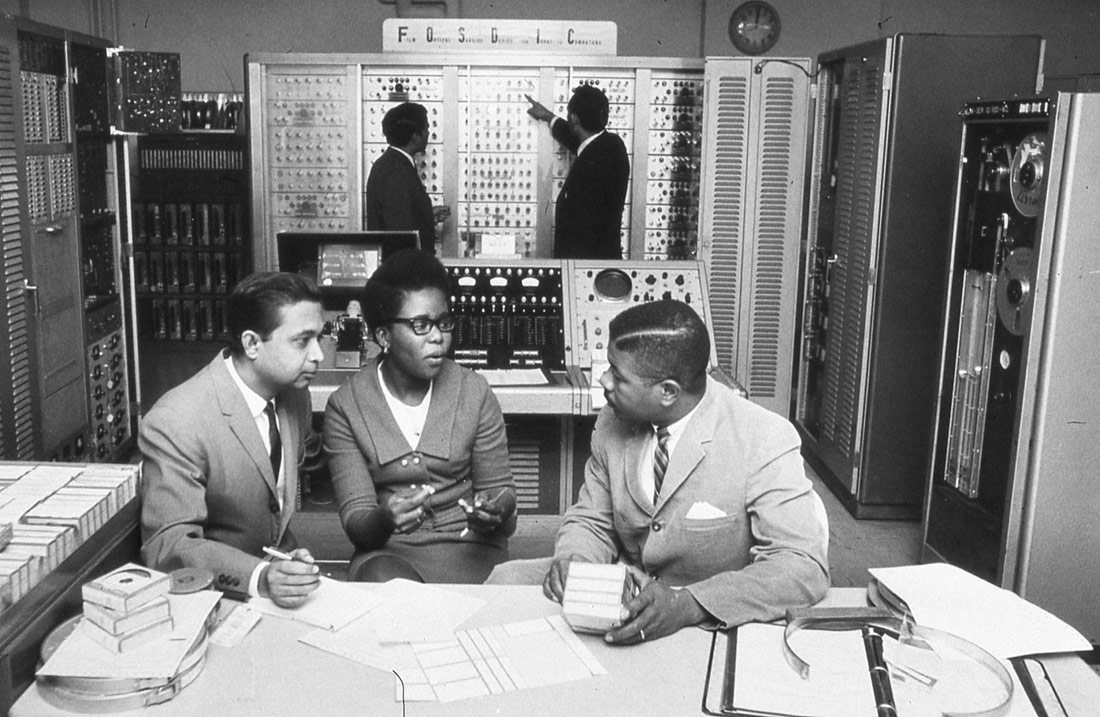

FOSDIC (Film Optical Sensing Device for Input to Computers) | U.S. Census Bureau | Dominio público

Es arriesgado reducir la ética a un cálculo matemático de daños y opciones posibles. Los algoritmos de aprendizaje automático se valen del contexto para tomar decisiones, sin una comprensión causal de los fenómenos que pretenden predecir. El conocimiento ético humano es prereflexivo, no es la mera conclusión de un argumento puramente racional, sino que es el resultado de un proceso formativo que empieza durante la infancia. Se trata de una esfera de la actividad humana a la que tenemos un acceso inmediato, de manera intuitiva, y es el resultado de compartir naturaleza y cultura. Esta intuición por el momento no es reducible a algoritmos, ni de los basados en reglas y definiciones, ni de los basados en similitudes estadísticas.

El juez examina detenidamente los informes que ha recibido. Consulta después sus notas y emite el veredicto: «Considerando su nombre de pila, su edad, el barrio en el que vive y sus notas de secundaria he decidido declararlo culpable del crimen del que se le acusa.»

Si un juez declarara algo así, el escándalo sería mayúsculo, pero la policía de Durham, en el Reino Unido, utiliza un sistema de aprendizaje automático conocido como HART (Harm Assessment Risk Tool, ‘Herramienta para establecer riesgos de daños’) para hacer predicciones de quién podría volver a realizar un crimen. El programa usa correlaciones como el tipo de barrio en el que la persona vive, su origen étnico (obtenido a partir del proxy del nombre de pila) y su grado de absentismo escolar para detectar una posible «juventud desconectada» que podría llevar a cabo crímenes contra la propiedad o las personas.

El problema no está en la efectividad del sistema. Aunque el programa fuera eficaz al 100% y acertara en todos los casos, seguiría siendo incompatible con nuestra idea de lo que es la justicia.

Una intuición básica sobre la que se basa nuestra idea de justicia fue capturada por el filósofo G. H. Von Wright en su libro Explicación y comprensión. Allí Von Wright argumentaba que, a la hora de dar sentido a nuestras vidas, utilizamos dos paradigmas diferentes: las causas y las razones. Según Von Wright, las causas nos explican por qué algo ha sucedido de la manera en la que ha sucedido, mientras que las razones nos permiten entender el porqué último de que algo haya sucedido. Las causas forman parte del razonamiento científico y nos explican en detalle cómo algo sucede. Las razones se encuentran en la esfera de las humanidades y nos explican el motivo de una situación, basándose en una comprensión humana, situada, de cómo entendemos el mundo y cuáles son nuestros valores.

El filósofo austríaco Ludwig Wittgenstein planteó esa intuición en uno de los aforismos de sus Investigaciones filosóficas, donde argumenta que si un juez decide declarar culpable a una persona lo hará por las razones que la llevaron a actuar. Si se guiara por las causas, siempre dejaría a la persona libre. Es decir, si buscamos la causa última de un comportamiento criminal, siempre encontraremos algo: abusos en la infancia, enfermedades mentales… en última instancia, siempre podremos decir que las neuronas de su cerebro adoptaron tal estructura y formación que llevaron inevitablemente a esa persona a cometer un delito. Son las razones por las que alguien actúa, y no las causas, lo que usamos para valorar la eticidad de un comportamiento.

Como he explicado en el primer artículo de esta serie (Sesgo en bucle: alimentando la injusticia algorítmica), los algoritmos actuales de aprendizaje automático se apoyan fuertemente en el contexto, y no tienen ningún tipo de comprensión causal de los fenómenos que tratan de predecir. Si por una casualidad todas las personas que se llaman David que viven en cierto barrio de Durham estuvieran ya fichados como criminales peligrosos y yo me fuera a vivir a ese barrio, tendría cada dos por tres a la policía en mi casa y me considerarían sospechoso de algún delito. Hasta no es difícil de imaginar que, harto de la presión, acabara cometiendo un delito de verdad.

Imaginemos que en un futuro conseguimos programas de inteligencia artificial capaces de llevar a cabo razonamientos causales correctos –cosa de la que aún estamos lejos, según expertos en el razonamiento de la IA como Judea Pearl. Aun así no tendríamos todavía una IA capaz de razonar como un juez, pues le faltaría disponer del conocimiento de las razones.

El filósofo Hubert Dreyfus, recientemente fallecido, ha argumentado esta posición de forma coherente en diversos artículos sobre en qué consistiría un conocimiento experto en ética. Dreyfus insiste en que un mero conocimiento discursivo, de causas, sobre qué es ético y qué no lo es, sería insuficiente para capturar los razonamientos éticos de una persona.

Un equipo de investigadores del MIT utiliza el famoso problema de la vagoneta, de la filósofa contemporánea Philippa Foot, para intentar enseñar a tomar decisiones éticas a los coches autónomos. La idea es que, ante un accidente inevitable en el que haya diversas opciones, el cerebro electrónico del coche inteligente tome la decisión moralmente más adecuada. Es, pues, un intento de reducir la ética a un cálculo matemático de daños y opciones.

Este sistema, aunque sin duda sería útil, no captura todos los matices que tiene una decisión humana. Básicamente, nuestro conocimiento ético es prereflexivo, no es simplemente la conclusión de un argumento puramente racional, sino que es el resultado de un proceso formativo que empieza en nuestra infancia, cuando tenemos una serie de experiencias personales que nos permiten dar sentido a nuestro mundo. Estas experiencias están fuertemente influidas por la sociedad y la cultura en las que vivimos. Nuestro conocimiento ético es espontáneo, intuitivo e inmediato. No establece verdades grabadas en piedra, sino que es fluido y revisa y reenmarca nuestra percepción de cuando una acción es ética o no en función de nuestras interacciones con otras personas y culturas. Este acercamiento se basa en una nuestra capacidad básica de dar sentido a nuestro entorno, capacidad que necesita una autonomía radical que nos permita establecernos como sujetos en el mundo.

Veamos otro ejemplo concreto. El año 2016, Facebook decidió retirar la icónica fotografía de la entonces niña de nueve años Kim Phúc sin ropa, huyendo de un ataque con napalm durante la guerra del Vietnam. Un algoritmo automático la había clasificado como «posible pornografía», y la había eliminado de la cuenta de un periodista noruego que desarrollaba un trabajo sobre el horror de la guerra. Fueron necesarias protestas del periódico e incluso del gobierno noruego, aparte de miles de usuarios indignados, para que Facebook diera su brazo a torcer y finalmente la fotografía volviera a la red social.

La respuesta oficial de Facebook cuando insistió en que no pensaban permitir esa fotografía es que era complejo dirimir cuándo una imagen de un menor sin ropa es apropiada y cuándo no. Y, efectivamente, si lo que buscamos es un algoritmo que nos diga si una fotografía es pornográfica o no en función de la cantidad de piel descubierta que hay, no vamos a encontrar nada. Para entender por qué la escena de «la chica del napalm» no es pornográfica sino que es una denuncia del horror de la guerra necesitamos entender muchas cosas sobre la naturaleza humana: qué nos da placer y qué nos genera sufrimiento, qué es un soldado, qué es una guerra, cómo se siente una criatura cuando ve caer llamas del cielo. Todo eso se escapa si simplemente estudiamos grados de semejanza entre la imagen de Kim Phúc huyendo y las fotografías que uno encuentra en un sitio como Pornhub.

Potter Stewart, juez del Tribunal Supremo de los Estados Unidos, presentó de manera perfecta el dilema cuando, el año 1964, al tener que decidir si determinada película era o no pornográfica, afirmó: «Hoy no intentaré definir los tipos de materiales que entiendo que deben incluirse dentro de esa descripción [“pornografía hardcore”], y quizás nunca conseguiría hacerlo de manera inteligible. Pero los reconozco cuando los veo, y la película involucrada en este caso no es eso.» «Los reconozco cuando los veo» resume perfectamente lo que busco describir en este artículo. Hay una esfera de actividad humana a la que tenemos un acceso inmediato, intuitivo, resultado de compartir una naturaleza y una cultura. Esa intuición no es reducible a algoritmos, ni los basados en reglas y definiciones ni los basados en similitudes estadísticas. Pero todos la reconocemos cuando la vemos.

Dreyfus creía que estas capacidades humanísticas estaban totalmente fuera del alcance de máquinas electrónicas. Por mi parte me confieso agnóstico sobre la cuestión. No veo ninguna razón ontológica o gnoseológica por la que no podamos tener un día verdaderas inteligencias artificiales, que rivalicen con nuestras capacidades humanas, aunque intuyo que ese día está todavía muy lejos.

Pero creo que hay una lección clara que debemos considerar: el desarrollo de las tecnologías digitales no ha de guiarse exclusivamente por criterios científicos y de mercado; hemos de incluir también una visión humanística que nos informe de cuándo tiene sentido un aparato o un algoritmo y cuándo es mejor confiar las decisiones a las intuiciones humanas.

Consuelo | 19 junio 2018

Muy interesante y clara reflexión. Gracias

Gonzalo Génova | 11 enero 2023

Un artículo excelente. Llego aquí por la referencia incluida en el trabajo de una alumna del curso «Inteligencia natural y artificial» que acabo de impartir en mi universidad (Carlos III de Madrid).

Tenemos muchos puntos en común, en mi blog he escrito mucho sobre la «moralidad algorítmica». Por ejemplo: Conformidad con la norma (https://demaquinaseintenciones.wordpress.com/2022/09/15/conformidad-con-la-norma/) y Utilitarismo: ¿se puede calcular la felicidad? (https://demaquinaseintenciones.wordpress.com/2021/11/21/utilitarismo-se-puede-calcular-la-felicidad/).

Sobre la cuestión apuntada en el penúltimo párrafo, «No veo ninguna razón ontológica o gnoseológica por la que no podamos tener un día verdaderas inteligencias artificiales», en mi opinión la clave para dar una respuesta negativa es esta: la pregunta no es si un ente material puede ser libre, sino si un ente DISEÑADO PARA UN FIN puede ser libre. Porque eso es la IA.

Deja un comentario