Fragmento de Radiolaria, serie de ilustraciones de Ernst Haeckel (1862). Fuente: Biodiversity Heritage Library | En: Harvard University.

El Big Data es el nuevo medio de este segundo decenio de siglo. Un nuevo conjunto de tecnologías computacionales que, al igual que las anteriores, ha cambiado el modo en que accedemos a la realidad. En un momento en que la web social es el nuevo laboratorio de la producción cultural, las humanidades digitales se vuelcan hacia el análisis de la producción y distribución masiva de productos culturales, para comprometerse en el diseño y cuestionamiento de los medios que la han hecho posible. De este modo, adoptan un enfoque más centrado en ver cómo se produce y distribuye la cultura, que las coloca ante los retos de una nueva cultura conectada.

5.264.802 documentos de texto, 1.735.435 archivos de audio, 1.403.785 vídeos y más de dos billones de páginas web accesibles a través de la WayBack Machine, constituyen el inventario actual del Internet Archive. A este podemos sumar las obras de más de 7.500 artistas de vanguardia, archivadas en forma de vídeos, pdf, archivos sonoros, programas de televisión y radio en UBUWEB, o las más de 4.346.267 entradas en 241 idiomas, facilitadas por los 127.156 usuarios activos que elaboran la Wikipedia y las continuas contribuciones de los más de quinientos millones de usuarios de Twitter. Estos son solo algunos ejemplos de los nuevos espacios virtuales donde se almacenan y comparten conocimientos. Archivos digitales, de acceso libre y contribuidos de modo colectivo, wikis y redes sociales, donde conviven hibridaciones y encuentros entre diferentes medios y múltiples contenidos. Dan lugar a un entorno complejo, donde nuestra cultura se muestra como un trabajo siempre en proceso.

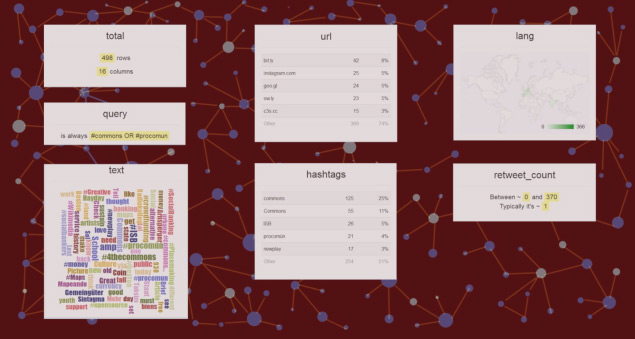

Visualización datos de Twitter. Generado con Scraperwiki.

En los años noventa el ordenador era visto como una «maquina de remediación», es decir, un medio capaz de reproducir los ya existentes. Entonces las humanidades digitales se centraron en la traducción de los documentos de nuestro patrimonio cultural, tributarios de la cultura de la imprenta, al medio digital. Un proceso de mediación en que los documentos fueron reducidos a datos discretos, legibles y operables por máquinas. La computación en humanidades, tal y como la describe Roberto A. Busa en la introducción a A Companion to Digital Humanities, es la automatización de todo análisis posible de la expresión humana. Esta automatización aportó nuevas capacidades a los documentos, que fueron mutando hacia un nuevo mensaje performativo, que desplazó al documento escrito como vehículo predominante del conocimiento humano. Al mismo tiempo, los propios procesos dedicados al análisis y reproducción de los textos se aplicaron al desarrollo de herramientas que permitieran acceder a estos contenidos y compartirlos, produciéndose un cambio del archivo a la plataforma. Ambas operaciones cambiarán el modo en que se lleva a cabo la investigación en las humanidades, definiendo el contenido de unas humanidades digitales 2.0.

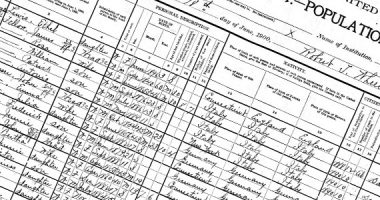

La conversión de documentos a código binario mediante el escaneado o la trascripción, su almacenaje en bases de datos, aprovechando las capacidades de estas para la búsqueda y recuperación de la información y la aplicación de descriptores, etiquetas y metadatos, dieron lugar al enlazado e interoperatibilidad de los medios. Se crearon archivos digitales como el Salem Witch Trial, dirigido por Benjamin Ray en la Universidad de Virginia en 2002, un repositorio de documentación referida a la caza de brujas de Salem, o The Valley of Shadow construido por el Centro para la Historia Digital en la Universidad de Virginia, y que documenta las vidas de la gente del Condado de Augusta en Virginia y del de Franklin en Pensilvania, durante el periodo de la Guerra Civil americana. Se convierten en espacios virtuales navegables, donde se accede a la información de modo activo, a través de una estructura que permite enlazar contenidos de diferentes bases de datos, almacenados en distintos formatos, sean imágenes, textos o archivos sonoros. Al mismo tiempo, la realización de estos repositorios, accesibles de modo casi ubicuo, supone un trabajo colaborativo entre profesionales de diversas disciplinas, desde historiadores, lingüistas y geógrafos hasta diseñadores e ingenieros informáticos. Este encuentro dará lugar a prácticas convergentes y a la postdisciplinariedad que definirá a las humanidades digitales. En este trabajo colaborativo en que se hibridan procedimientos y formas de representación, aparecen nuevos formatos donde contextualizar la información, desde el esquema cronológico hasta los mapas geográficos y las timelines. En este sentido, hay de mencionar el proyecto Digital Roman Forum, llevado a cabo entre 1997 y 2003 por el Cultural Virtual Reality Laboratory (CVRLab) de la Universidad de California, Los Ángeles (UCLA). Este muestra un nuevo modo de espacializar la información, creando un modelo tridimensional del Foro romano que funciona como interfaz, conteniendo distintas cámaras, enfocadas a los diferentes monumentos reproducidos. Este dispositivo permite comparar la reproducción histórica con fotografías actuales, al mismo tiempo que ofrece una relación de los distintos documentos que hacen referencia a estos espacios y que han sido usados para la realización de la reproducción.

Esta capacidad de acceso y enlace es llevada más allá del archivo por proyectos como Perseus o Pelagios, espacios en que se accede a los contenidos y se contribuye a los mismos de modo colectivo y libre. Estos hacen uso de los estándares surgidos en las comunidades de práctica, para relacionar sus contenidos a través de diferentes recursos en línea, deviniendo, más que repositorios, auténticas plataformas donde producir y compartir conocimiento. Así, la librería digital Perseus, iniciada en 1985, se basa en la elaboración de un software opensource, que permite un sistema de operación de datos extensible en un espacio de trabajo en red, a través de un sistema que funciona a dos niveles, uno accesible a los seres humanos, que permite añadir contenidos y descriptores, y otro que incorpora la capacidad de generar conocimiento de las máquinas. Esta plataforma da acceso a los documentos originales, relacionándolos con múltiples informaciones, como sus traducciones y reediciones posteriores, ediciones de comentarios, mapas de los espacios citados… Toda esta información es exportable en archivos de datos en formato xml. El proyecto Pelagios, dedicado a la reconstrucción del mundo antiguo, elabora un mapa en el que datos geoespaciales históricos son relacionados con contenidos en otras fuentes de recursos en línea. El acceso a un punto del mapa-interfaz nos conduce a un conjunto heterogéneo formado por imágenes, traducciones, citas, bibliografías u otros mapas, todo exportable en varios formatos de archivos de datos como son xml, Json, atom o klm.

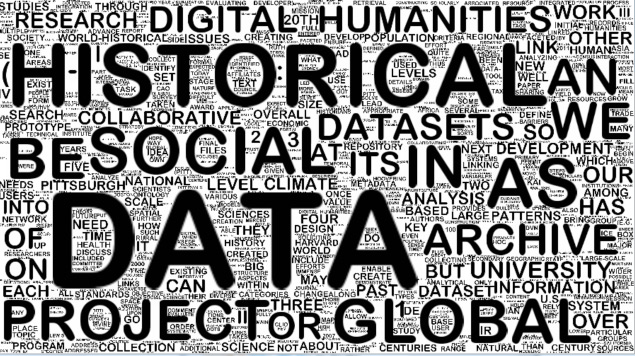

WorldCloud de los abstracts del último congreso de la ALLC: The European Association for Digital Humanities. Generado con Processing.

Estos proyectos ponen en evidencia el giro computacional en las humanidades del que nos habla David M. Berry en The Computational Turn: Thinking about Digital Humanities: Las técnicas computacionales no son solo un instrumento al servicio de los métodos tradicionales, sino que tienen un efecto en todos los aspectos de las disciplinas. No solo introduciendo nuevos métodos dirigidos a la identificación de nuevos patrones en los datos, que van más allá de la narrativa y comprensión tradicionales, sino permitiendo la modularización y recombinación de las disciplinas, más allá del ambiente académico tradicional. La aplicación de la automatización ligada a la digitalización no solo ofrece nuevas capacidades de análisis de los documentos textuales, sino que también da lugar a nuevas capacidades de recombinación y producción de conocimiento, así como al surgimiento de nuevas plataformas, esferas públicas, donde la distribución de la información ya no puede pensarse de modo independiente a su producción.

Este giro computacional es descrito en The Digital Humanities Manifesto 2.0, redactado en 2009 por Jeffrey Schnapp y Todd Presner, como la conversión del primer impulso cuantitativo de las humanidades digitales a uno cualitativo, interpretativo, emotivo y generativo. Este está más implicado en la complejidad y la especifidad del medio, su contexto histórico, su crítica e interpretación. Una reformulación de objetivos en que los medios digitales son considerados como profundamente generativos, y en que se analizan los modos nativos digitales del discurso y la investigación, surgidos en las esferas públicas emergentes, como son los wikis, la blogosfera, y las librerías digitales. Ello permite comprometerse en el diseño de las herramientas, el software, que ha dado lugar a esta nueva forma de producción de conocimiento, así como en el mantenimiento de las redes en que se produce esta cultura. Está caracterizada por ser opensource, dirigida a múltiples propósitos y distribuida en múltiples canales. Surge de la colaboración de un modo procesual y en que el conocimiento asume múltiples formas, desde la composición de imágenes hasta la orquestación musical, la crítica de textos y la fabricación de objetos, en una convergencia entre el arte, la ciencia y las humanidades.

La capacidad generativa de los nuevos medios y su capacidad de comunicación han dado lugar a la distribución y producción masiva de productos culturales. En esta época que Manovich denomina del more media, es el momento de pensar la cultura en términos de datos. Datos no solo procedentes de la tradición almacenada en los archivos digitales, sino también producidos de modo digital a partir de los metadatos, los tags, la visión computerizada, las huellas digitales, las estadísticas y los metacanales –blogs y comentarios en redes sociales que hacen referencia a otros contenidos–, datos que pueden ser minados y visualizados. Citando la última obra de este autor, «Sofware takes command». Si el análisis, el minado y la visualización de datos han sido adoptados por los científicos, negocios y gobiernos como un nuevo modo de generar conocimiento, podemos aplicar la misma comprensión a la cultura. De este modo, los métodos aplicados a la computación social –el trazado y análisis de datos producidos en nuestras interacciones con el entorno, para una mayor eficiencia en la oferta de productos de consumo o la planificación de nuestras ciudades– podrían ser usados para hallar nuevos patrones en la producción cultural. Estos permitirían no solo desarrollar nuevas categorías, sino también trazar y seguir cómo y con qué herramientas se produce esta cultura. La analítica cultural aplicada en el Software Studies desde 2007 es una propuesta en este sentido. Esta consistente en el desarrollo de herramientas de visualización que permitan analizar conjuntos masivos de productos culturales, especialmente imágenes. De este modo, a partir del software ImagePlot y de pantallas de gran resolución, se llevan a cabo proyectos en que se parametrizan grandes conjuntos de imágenes. Estas permiten descubrir nuevos patrones que cuestionan las categorías del análisis cultural. Entre estos proyectos, Phototrails permite visualizar patrones visuales y estructuras dinámicas en fotos generadas y compartidas por los usuarios de diferentes redes sociales.

En otra línea, existen proyectos que analizan las huellas digitales para seguir la producción y distribución del conocimiento. Es el caso del History Flow de Martin Wittenberg y Fernanda B. Viégas –desarrollado en el Collaborative User Experience Reserach Group de IBM–, que construye un histograma de las aportaciones que conforman la Wikipedia.

El uso del Big Data, aplicado a la producción cultural, nos permite representar de modo continuo y espacial cómo se conforma nuestra cultura visual y cómo se produce el conocimiento, poniendo a las humanidades digitales ante los nuevos retos de una cultura de datos generada en red. Retos que vinculan el análisis del software con cuestiones epistemológicas, pedagógicas y políticas. Estos plantean diferentes cuestiones, entre ellas: el modo en que se obtienen los datos; qué entidades parametrizamos, a riesgo de dejar fuera de la representación partes de la realidad; cómo asignamos valor a estos datos, teniendo en cuenta que ello tendrá un impacto directo en cómo estos podrán ser visualizados, así como que la visualización tiene una gran fuerza retórica, en virtud de sus capacidades gráficas, por lo que puede distorsionar estos datos; cómo se estructura la información en los entornos digitales, ya que esta estructuración supone un modelo de conocimiento y una ideología; cómo mantenemos estándares que permitan la interoperabilidad de los datos, y cómo afrontamos la tarea política de hacer que estos datos sean de acceso libre; qué nuevas formas de narrativa no lineal, multimedia y colaborativa se pueden desarrollar a partir de estos datos; la cuestión pedagógica de cómo instruir en la comprensión del código digital y del medio algorítmico a humanistas educados en la división entre cultura y ciencia, y por último, cómo acercar a las instituciones culturales al laboratorio, haciendo que se comprometan, ya no en la preservación, sino en la participación y el mantenimiento de las redes que hacen posible la producción del conocimiento.

Deja un comentario